Site blog

The goal for this information and my book, is to get you up and running Kubernetes. The recommended way, is to read the information in this order:

1. Overview (this blog entry): to get overview about control plane.

2. Pod(Pods): to get information about pod (to be posted).

3. kubectl: the CLI tool to handle the cluster (to be posted).

4. Service: to get information about service and how to work with these (to be posted).

5. Namespaces: to get information about namespaces and how to work with namespaces to isolate resources on the cluster (to be posted).

6. Helm: to get information about Helm (to be posted).

7. Managed Services (Cloud): to get information about managed services for Kubernetes in the Cloud (Azure, GCP and aws) (to be posted).

Overview

Kubernetes is a portable, extensible, open-source platform for managing containerized workloads and services, that facilitates both declarative configuration and automation. It has a large, rapidly growing ecosystem. Kubernetes services, support, and tools are widely available.

The name Kubernetes originates from Greek, meaning helmsman or pilot. K8s as an abbreviation result from counting the eight letters between the "K" and the "s". Google open-sourced the Kubernetes project in 2014. Kubernetes combines over 15 years of Google's experience running production workloads at scale with best-of-breed ideas and practices from the community.

Components

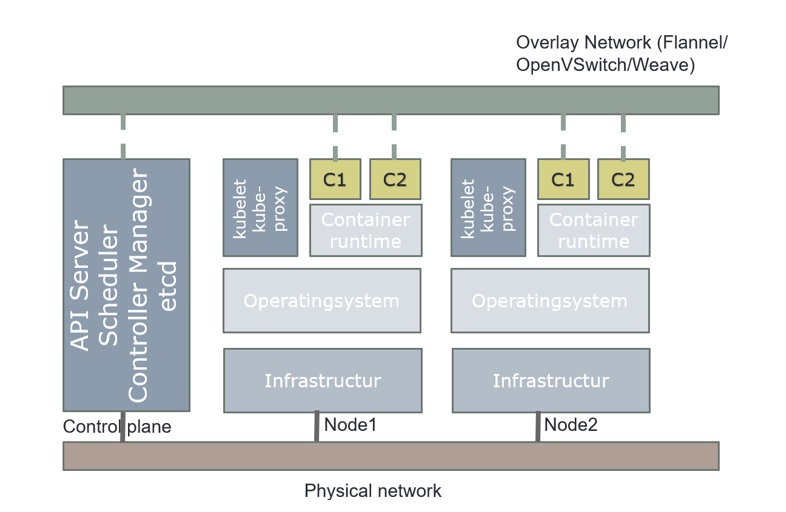

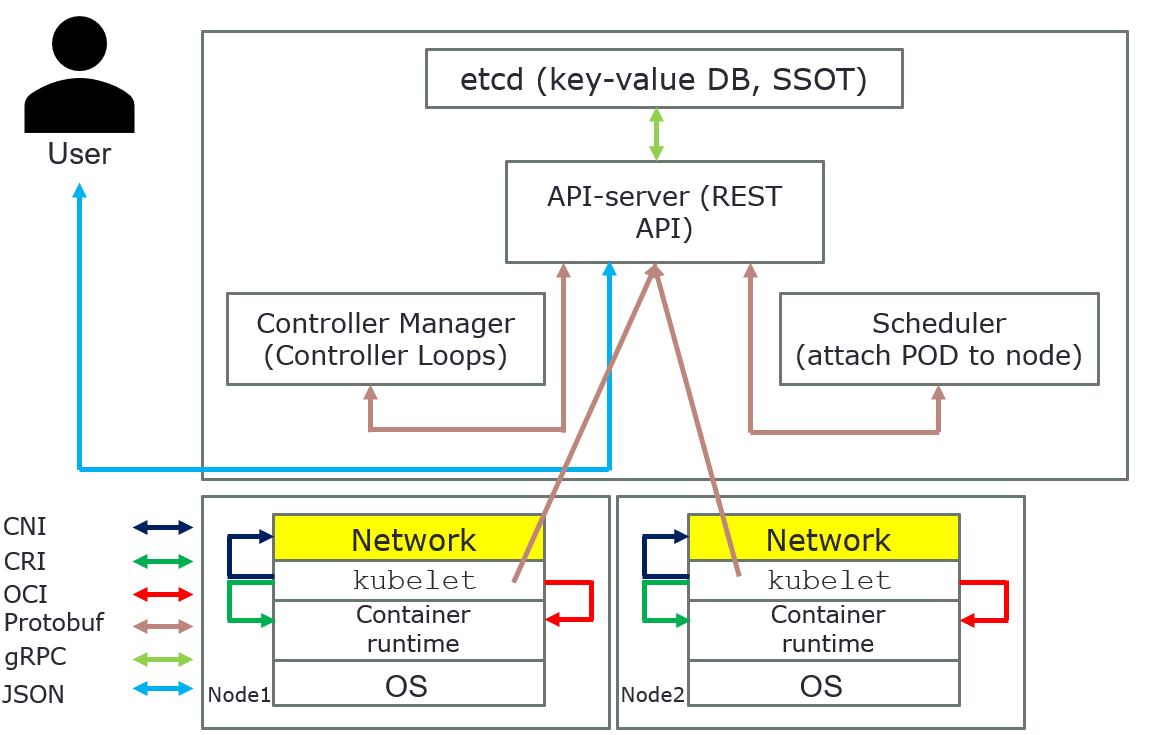

When you deploy Kubernetes, you get a cluster.

A Kubernetes cluster consists of a set of worker machines, called nodes, that run containerized applications. Every cluster has at least one worker node.

The worker node(s) host the Pods that are the components of the application workload. The control plane manages the worker nodes and the Pods in the cluster. In production environments, the control plane usually runs across multiple computers and a cluster usually runs multiple nodes, providing fault-tolerance and high availability.

The control plane's components make global decisions about the cluster (for example, scheduling), as well as detecting and responding to cluster events (for example, starting up a new pod when a deployment's replicas field is unsatisfied). Kubernetes use Desired State Configuration, it compares desired configuration against the running configuration, and make changes when the desired configuration is not satisfied.

Control plane components can be run on any machine in the cluster. However, for simplicity, set up scripts typically start all control plane components on the same machine, and do not run user containers on these machines. Components for control plane are: API server, etcd, scheduler, and controller-manager.

API server

The API server is a component of the Kubernetes control plane that exposes the Kubernetes API. The API server is the front end for the Kubernetes control plane.

The main implementation of a Kubernetes API server is API server. API server is designed to scale horizontally—that is, it scales by deploying more instances. You can run several instances of API server and balance traffic between those instances.

etcd

Consistent and highly available key value store used as Kubernetes' backing store for all cluster data. etcd is used as a Single Source of Truth (SSOT). In production it´s vital to provide fault-tolerance and high availability for etcd. At least, use three (3) machines for etcd.

Scheduler

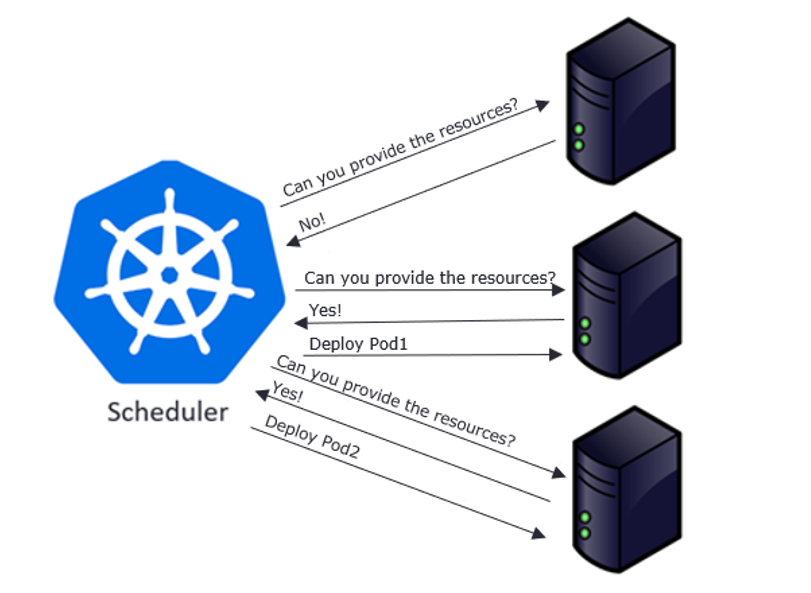

Control plane component that watches for newly created Pods with no assigned node and selects a node for them to run on. It attempts to reach the desired state as per etcd values from current state.

Factors considered for scheduling decisions include individual and collective resource requirements, hardware/software/policy constraints, affinity and anti-affinity specifications, data locality, inter-workload interference, and deadlines.

Scheduling starts with finding suitable nodes that have resources that can host a pod. For example, if a pod has specific sets of requirements in terms of CPU and Memory passed in the request, then only those nodes will be selected that have these requirements. This is handled by a set of predicates which execute in chain filtering nodes for each given parameter, like ports, hostname, resources, node pressure in terms of processes and CPU usage.

As nodes get evaluated against the parameters, each node gets a ranking showing their suitability, with the highest-ranking node finally getting selected. Once node is selected a binding object is created which has namespace, pod name and uid with reference to the node selected. This binding object then ends up getting sent to API Server via a POST. Once the API Server receives this request it updates the etcd entry for the pod object with the given node name and changes the PodScheduled to true. Once this update is done, it’s time to get the pod running on a worker node.

At this point the object exists in etcd with no actual physical resources assigned. Next the object will be sent over to the set of nodes referenced to the object in etcd. This is done by a pull mechanism executed by kublet.

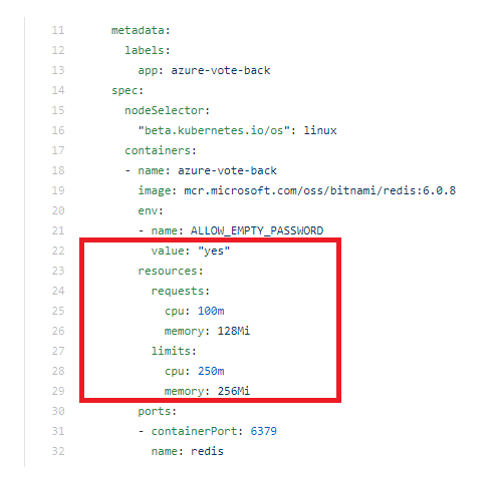

Limits and request

A pod in Kubernetes can freely consume resources, such as CPU and memory, from the underlying system. But that doesn't mean it should.

IT teams define limits that restrict pods from using all the resources of the system. That way, there isn't any unfair distribution of resources across applications running on the pods.

To understand these configurable constraints, first let's examine requests and limits in Kubernetes. Both are applied at the pod level. The Kubernetes scheduler uses this information to determine where to place a pod.

- A request is the minimum resources a container needs on a node to function properly. If there aren't nodes with sufficient resources to meet these requests, the pod won't be created.

- A limit sets the maximum amount of a resource that a container can use. If a container consumes more than its limit, then it's either throttled down (in the case of CPU) or the container is terminated (in the case of memory). Limits ensure containers don't consume more resource than they're assigned, which leads to resource exhaustion

Choosing practical requests and limits

Setting requests and limits correctly is critical to the Kubernetes cluster. But setting pragmatic Kubernetes requests and limits is not a straightforward task. It can also be unpredictable.

Use trial and error to determine the appropriate limitations. There can't be a one-size-fits-all or optimal value for all containers. Resource consumption depends on the application and varies on a case-by-case basis.

Ideally, maintain a 20% to 30% margin during request setup so that, even if slightly more resources are required than allocated, it can be managed easily. But don't overcommit resources, as it can result in performance bottlenecks on the node.

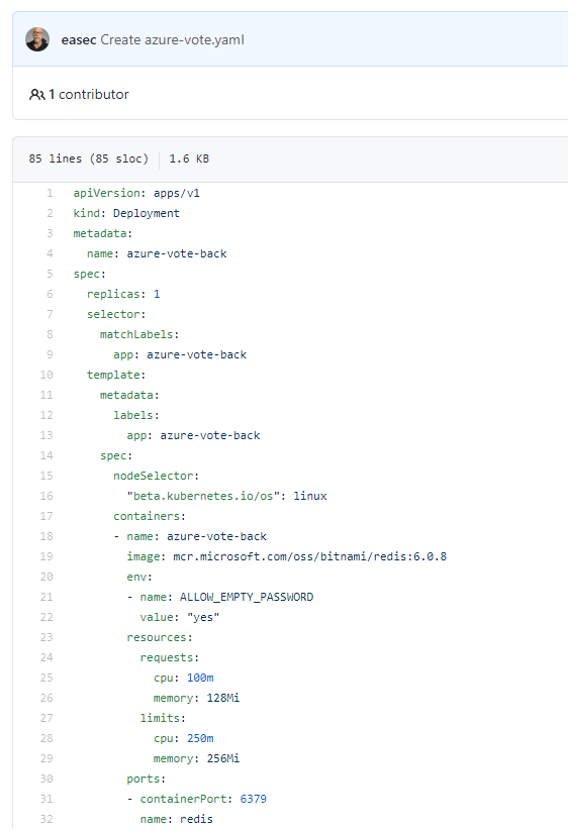

Setting requests and limits

Setting up Kubernetes requests and limits on pods is as simple as applying the pod configuration file below, with requests and limits set for CPUs in "millicpu" and for memory in "MiB."

To apply these settings, use following command:

kubectl apply -f <name_for_yaml file> --namespace=<name_for_namespace>

For more information about namespace, see the section Namespaces.

Deault requests and limits

Developers should set their own resource requests and limits. But sometimes they either over-provision resources for containers out of an abundance of caution or forget to set requests and limits altogether. Therefore, Kubernetes cluster administrators should enforce requests and limits on a Kubernetes namespace level. This ensures that, as soon as a container is created in the namespace, resource bounds are applied to them automatically.

There are two ways to control resource consumption on a Kubernetes namespace: Resource Quotas and Limit Ranges. For more information about namespace, see the post for Namespaces.

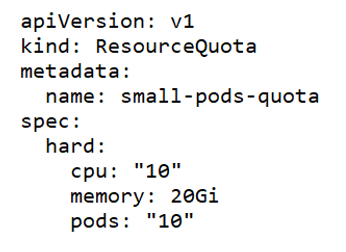

Resource Quotas

A ResourceQuota limits the total resource consumption of a namespace. For example, in the following YAML configuration, the namespace has a hard limit of 10 CPUs, 20 Gi of memory and 10 pods.

Limit Ranges

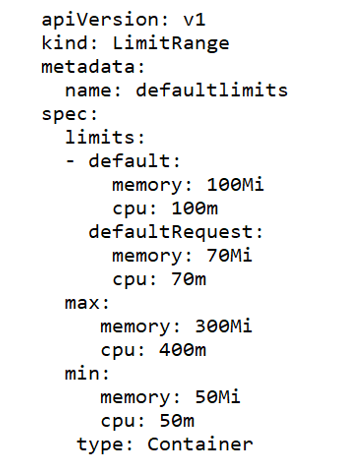

LimitRange objects manage constraints at a pod/container level, and the configurations are applied on individual containers, rather than across all resources in a namespace. If a container doesn't specify its own container limit, then a "LimitRange" object will apply default requests and limits, which are restricted by the ResourceQuota at the namespace level.

LimitRange objects are defined as shown in the following example YAML configuration, where "max" and "min" sections cover the maximum and minimum limits of resources. The "default" section configures containers with these default limits, if not explicitly specified otherwise. Finally, the "defaultRequest" section controls the assignment of default request values for the container, if not defined already.

Controller-manager

Controller-manager is a Control Plane component that runs controller processes.

Logically, each controller is a separate process, but to reduce complexity, they are all compiled into a single binary and run in a single process.

Some types of these controllers are:

- Node controller: Responsible for noticing and responding when nodes go down.

- Job controller: Watches for Job objects that represent one-off tasks, then creates Pods to run those tasks to completion.

- Endpoint’s controller: Populates the Endpoints object (that is, joins Services & Pods).

- Service Account & Token controllers: Create default accounts and API access tokens for new namespaces.

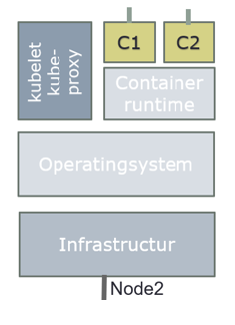

Node Components

Node components run on every node, maintaining running pods and providing the Kubernetes runtime environment.

kubelet

An agent that runs on each node in the cluster. It makes sure that containers are running in a Pod.

The kubelet takes a set of PodSpecs that are provided through various mechanisms and ensures that the containers described in those PodSpecs are running and healthy. The kubelet doesn't manage containers which were not created by Kubernetes.

Example:

kublet polls API Server for pods bound to the node it is running on by default every 20 seconds. If it detects a change compared to its own state, it begins to synchronize to the new state.

It works through following steps:

1. If it’s a new pod, register it and publish startup metrics.

2. Generate a pod status object with possible values like Pending, Running, Succeeded, Failed and Unknown, as these represent the states a pod can be in. It is determined by running pod specs to through a chain of PodSyncHandlers. Each handler checks if pod should run on the node or not. If any one of these fails, the pod will transition to evicted state.

3. Upon generation of Pod status, it will be sent to etcd for updating. Pod is then running through a set of node level admission handlers like AppArmor profiles and privilege evaluations.

4. If pod has specific cgroup requirements, these will be enforced and attached to the pod.

5. Data directories are then created for pod data, volumes, and related plugins.

6. Any volumes required will be created and attached.

7. Secrets, if needed, are pulled from API server, and made available for injection into the pod.

8. Image-related info such as secrets and url is gathered and made available for the container runtime to execute.

9. Finally, all this info is passed to container runtime to actually run the container.

The time has now come to make our container live by making it run on the physical resources. This is achieved by invoking CRI (Container Runtime Interface), which is an interface layer between Kubernetes and container runtimes, such as docker, containerd, rkt and more.

kube-proxy

kube-proxy is a network proxy that runs on each node in your cluster, implementing part of the Kubernetes Service concept. kube-proxy maintains network rules on nodes. These network rules allow network communication to your Pods from network sessions inside or outside of your cluster. kube-proxy uses the operating system packet filtering layer if there is one and it's available. Otherwise, kube-proxy forwards the traffic itself.

Container runtime

The container runtime is the software that is responsible for running containers.

Kubernetes supports several container runtimes: Docker, containerd, CRI-O, and any implementation of the Kubernetes CRI (Container Runtime Interface).

Overview how everything is connected in Kubernetes

The above pictures are just for an overview, it´s show how everything is connected in Kubernetes.

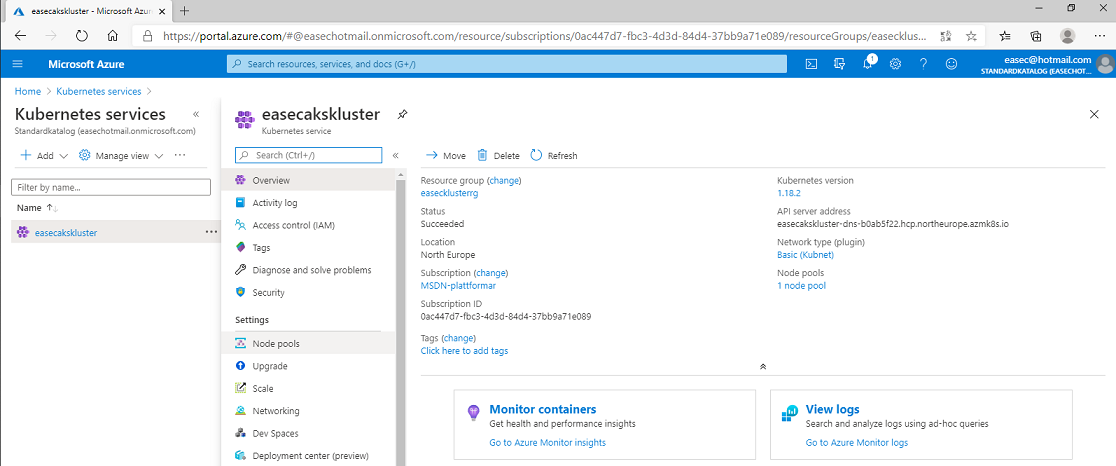

Denna inspelade demonstration visar hur du skapar ett kluster för Kubernetes i AKS. I demonstrationen visar jag hur du skapar klustret via portal, men du kan även göra detta via exempelvis Cloud Shell:

az aks create \

--resource-group <namn_för_resursgrupp> \

--name <namn_för_kluster> \

--vm-set-type VirtualMachineScaleSets \

--node-count <antal_noder> \

--generate-ssh-keys \

--kubernetes-version <versionsnummer> \

--load-balancer-sku standard

Demonstrationen finns med i .easec:s kurser: Orkestrering i Docker och Azure för administratören.

Ja

mina vänner, allt har sin början och sitt slut som jag brukar säga! .easec

började av en slump för tio år sedan, när jag var utlokaliserad till Söndraby.

Hade ett arbete och arbetsgivare som jag trivdes väldigt bra med, men av

privata skäl var jag tvungen att avsluta detta. Och nu avslutas denna epok av

en slump! Hade ett bra möte i våras och detta ledde till att jag fick ett

förslag som jag tyckte var riktigt intressant och på måndag (1 juni) kommer jag

att börja på KnowIT Cloud AB (https://www.knowit.se/om-knowit/).

Men det har varit en fantastisk resa och vad många roliga och intressanta människor jag har träffat! Jag har fått resa en hel del inom Sverige, det finns 290 kommuner och jag har varit i 282 av dessa kommuner. De flesta i tjänsten så att säga, men några privat. Även om Skåne naturligtvis är vackrast, så har det slagit mig många gånger, under mina tågresor, att Sverige är fantastiskt oavsett var du kommer!

En del av de jag har träffat, har jag kunnat följa och se hur de har utvecklas och fått bra och intressanta arbetsuppgifter, detta har gett en skön känsla för mig. I de längre utbildningarna har jag försökt att förmedla mina egna tankar och idéer, som kommer från idrottsvärlden. Grundtanken i min filosofi är att det finns inget problem som är för stort och som man inte kan ta sig igenom. Delar man upp problemet i mindre bitar, så är det mycket lättare att lösa och till slut har man även löst det stora problemet. En annan viktig del i min filosofi, är att vara nyfiken!

.easec kommer inte att försvinna, utan kommer att finnas kvar och fortsätta att vara, troligtvis, Sverige:s största oberoende leverantör av IT-utbildningar. Drygt ett femtiotal kurser och ett stort antal användare på portalen!

Förutsättning: Konto för GCP.

Arbetsuppgift 1: Anslut till konsol för GCP och logga på

1. Öppna webbläsare och skriv in URL: https://console.cloud.google.com och klicka på Enter.

2. Logga på med dina inloggningsuppgifter.

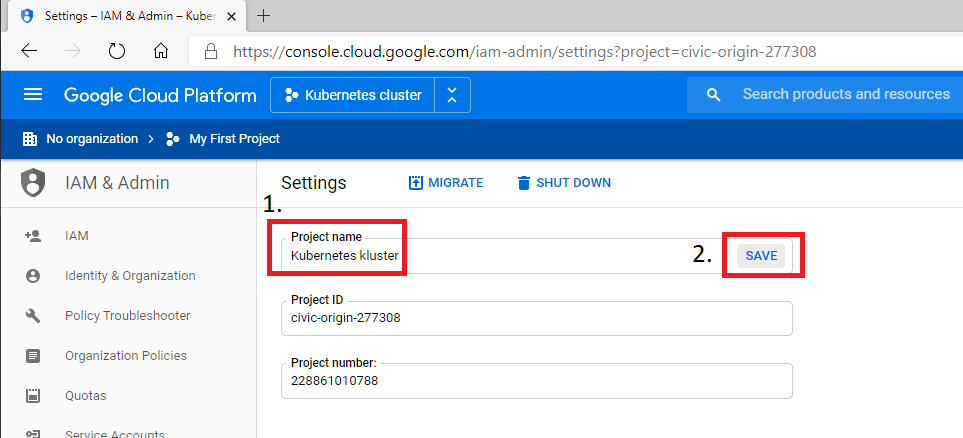

Arbetsuppgift 2: Skapa projekt och verifiera att API är påslaget

1. I konsol, expandera Navigation menu på vänstra sidan och klicka på IAM & Admin – Settings.

2. I fältet under Project name, skriv in nytt namn för ditt projekt, klicka sedan på SAVE.

3. Återinläs sidan och namnet kommer att förändras.

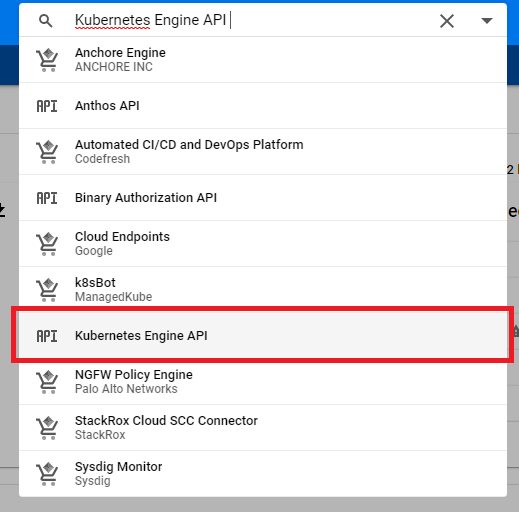

4. I konsol, expandera Navigation menu på vänstra sidan och klicka på APIs & Services - Dashboard.

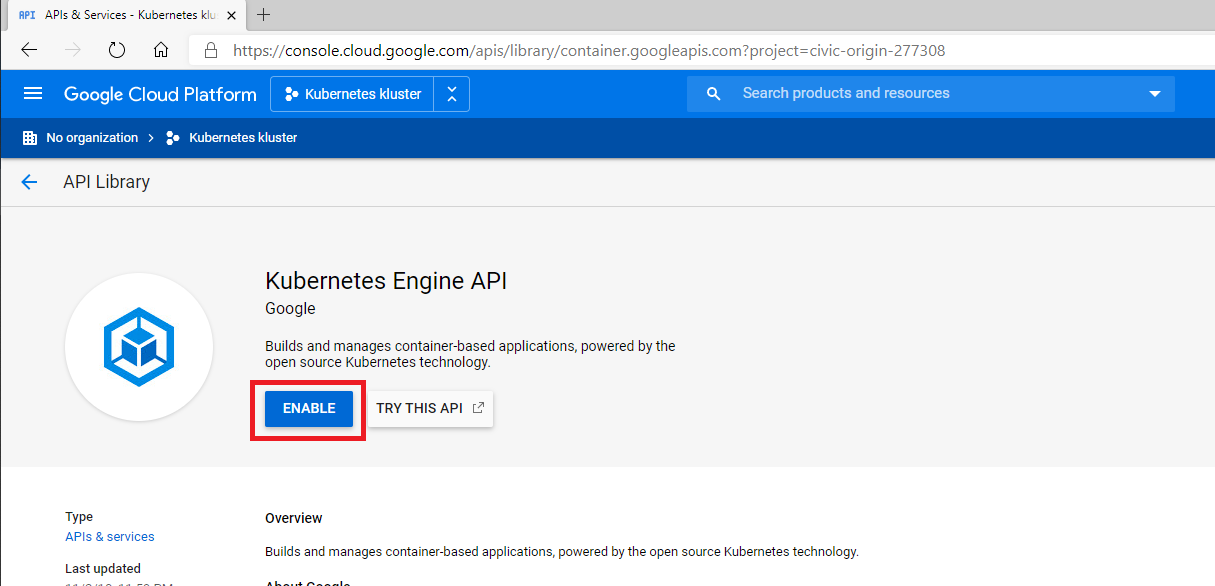

5. Skriv in Kubernetes Engine API i sökrutan och klicka på Enter. Klicka på Kubernetes Engine API i sökresultatet.

6. Klicka på ENABLE (Om API redan är påslaget, kommer det att stå DISABLE). Detta kommer att ta några minuter.

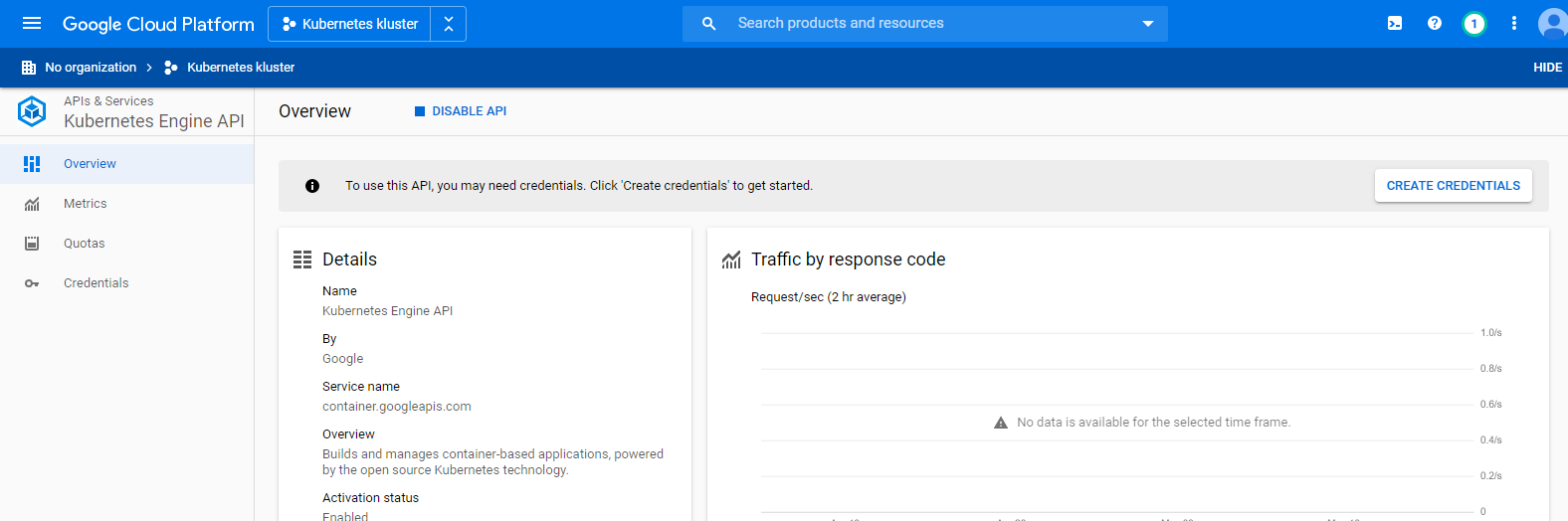

7. När API är påslaget kommer översiktsbild att visas.

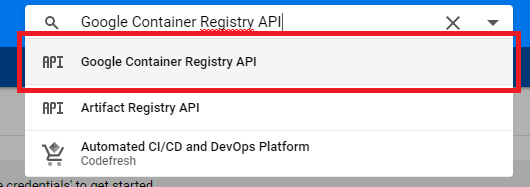

8. Skriv in Google Container Registry API i sökrutan och klicka på Enter. Klicka på Google Container Registry API i sökresultatet.

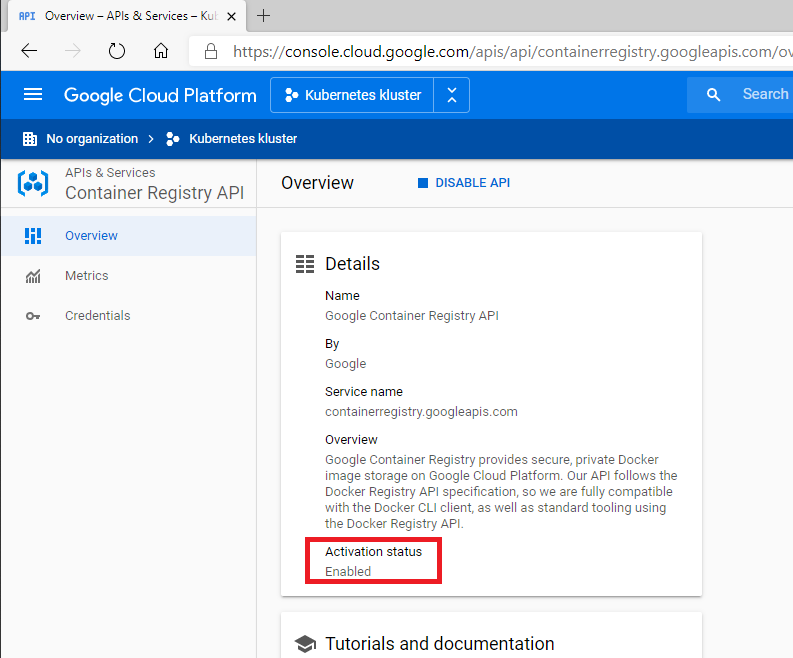

9. Verifiera att det står Enabled under Activation status.

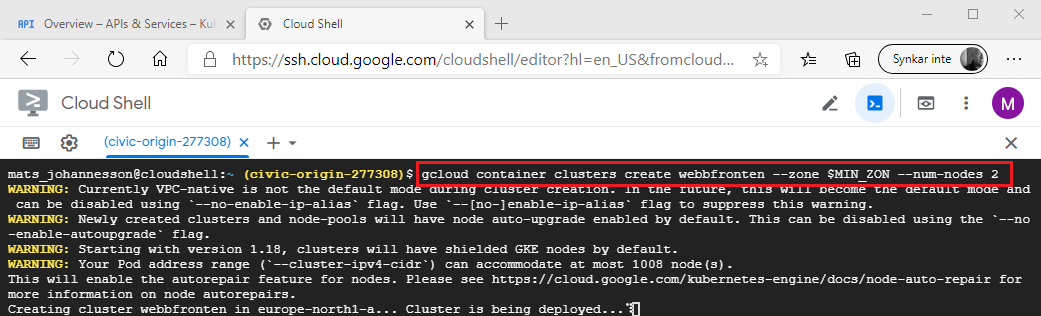

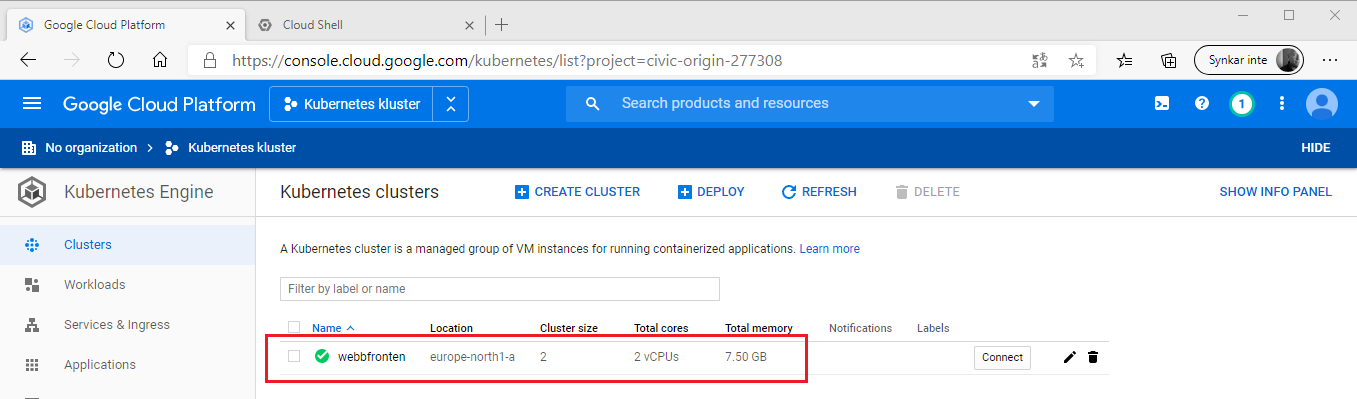

Arbetsuppgift 3: Skapa kluster

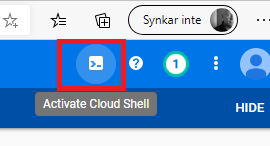

1. I den högra övre delen av konsol, klicka på ikon >_ (Activate Cloud Shell).

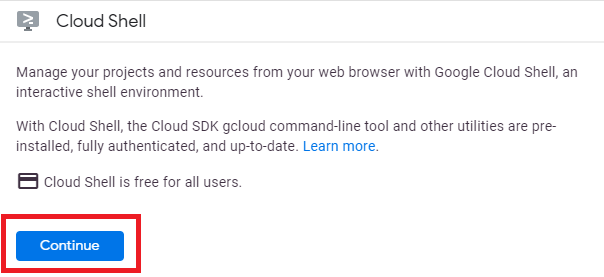

2. I nedre delen av konsol, klicka på

Continue. Virtuell maskin med Cloud Shell kommer att skapas och startas.

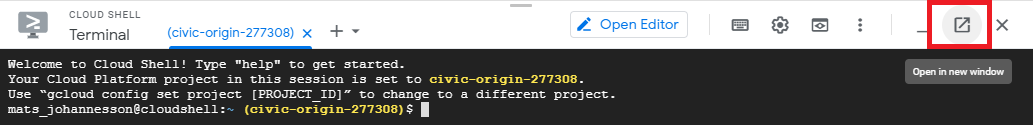

3. Istället för att arbeta i den nedre delen av konsolen, klicka på ikon för Open in new window, för att öppna ett nytt fönster med Cloud Shell.

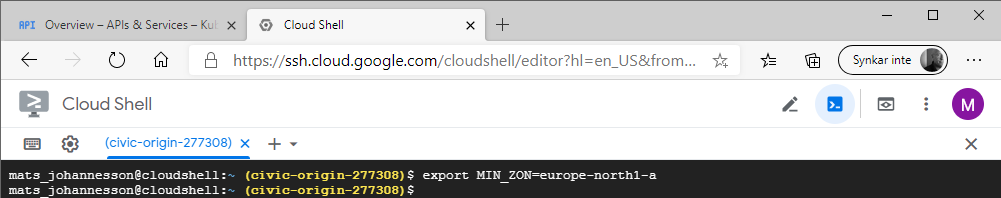

4. Skriv in följande kommando och klicka på Enter, för att skapa variabel som innehåller namnet för den zon där du kommer att skapa klustret:

export MIN_ZON=europe-north1-a

För att se vilka zoner som finns tillgängliga, använd följande kommando:

gcloud compute zones list

5. Skriv in följande kommando och klicka på Enter, för att skapa kluster för webbfrontend med två (2) noder:

gcloud container clusters create webbfronten --zone $MIN_ZON --num-nodes 2

6. Efter en stund kommer klustret vara

klart, verifiera att STATUS visar RUNNING.

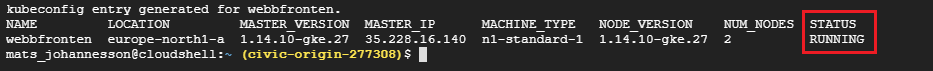

7. Skriv in följande kommando och klicka på Enter, för att kontrollera version:

kubectl version

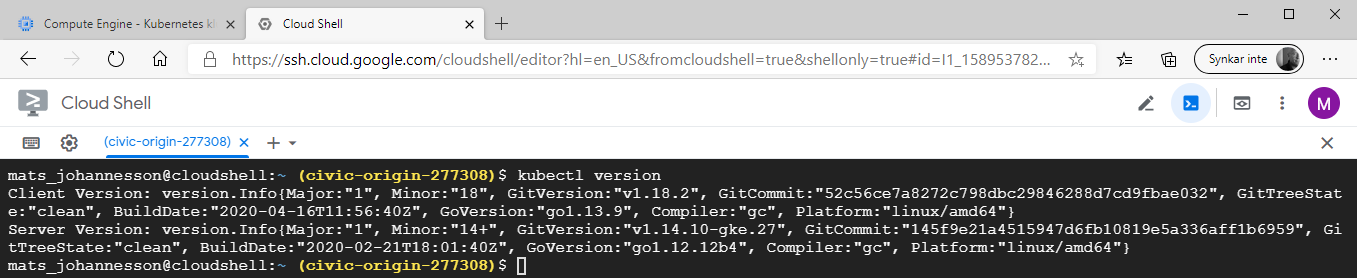

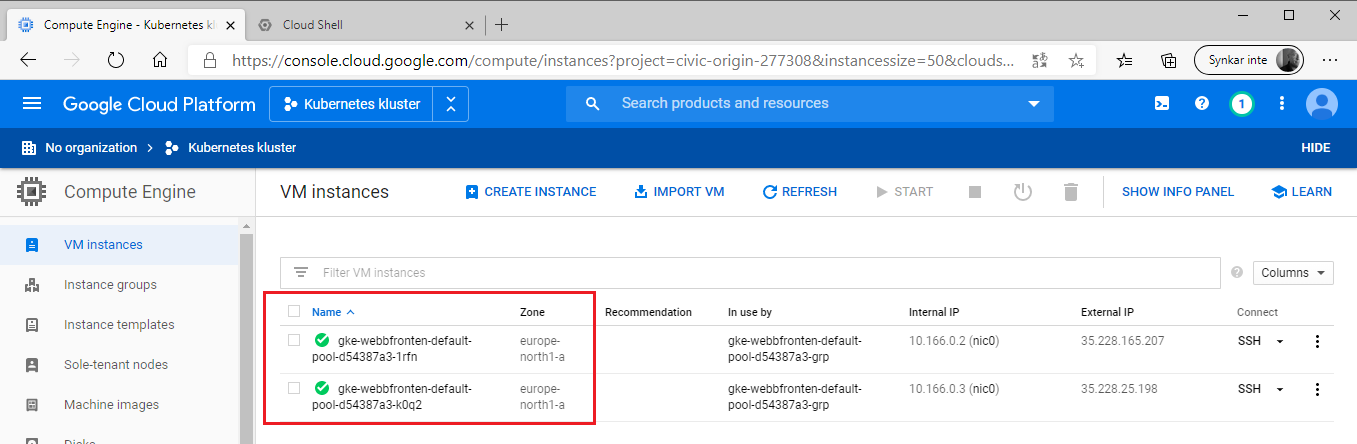

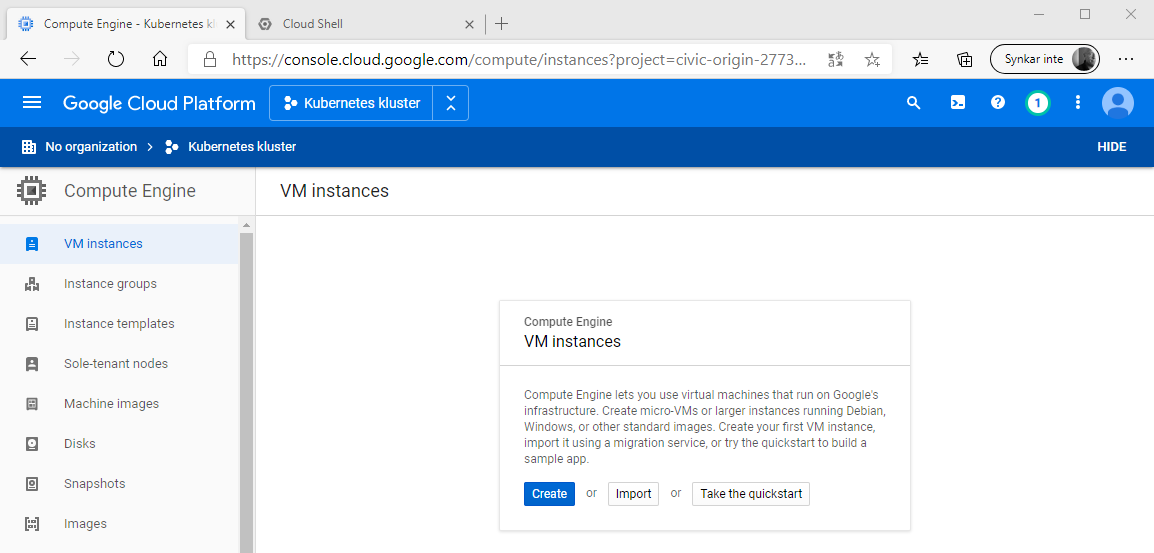

8. Återgå

till konsol, expandera Navigation menu på vänstra sidan och klicka på Compute

Engine, verifiera att noder som du skapade är virtuella maskiner och att dessa

finns i den zon som du specificerade.

9. Du kan även se klustret genom att expandera Navigation menu på vänstra sidan och klicka på Kubernetes clusters, verifiera att klustret som du skapade tidigare visas.

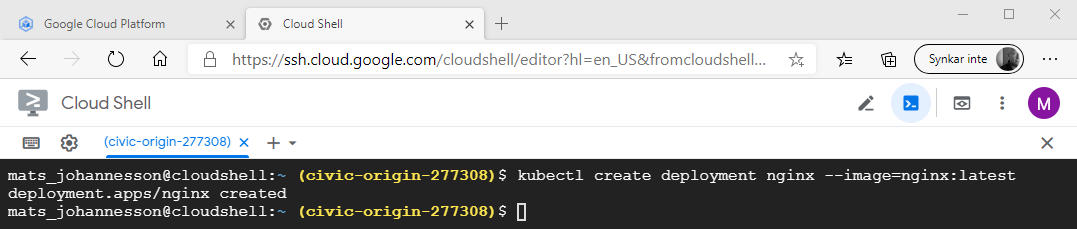

Arbetsuppgift 4: Skapa deplyment för nginx

1. Återgå till fönstret för Cloud Shell.

2. Skriv in följande kommando och klicka på Enter, för att skapa deployment för nginx:

kubectl create deployment nginx --image=nginx:latest

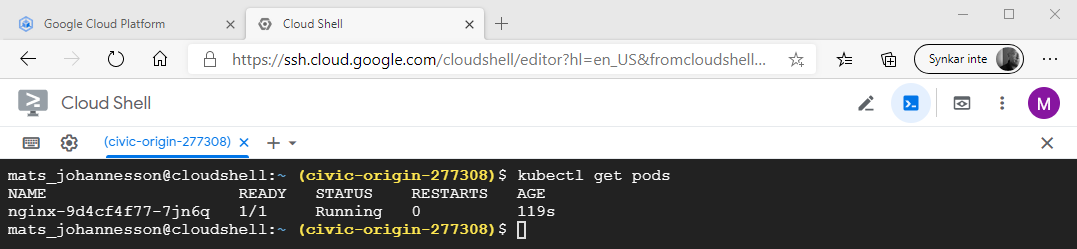

2. Deployment består av en pod, för att verifiera detta skriv in följande kommando och klicka på Enter:

kubectl get pods

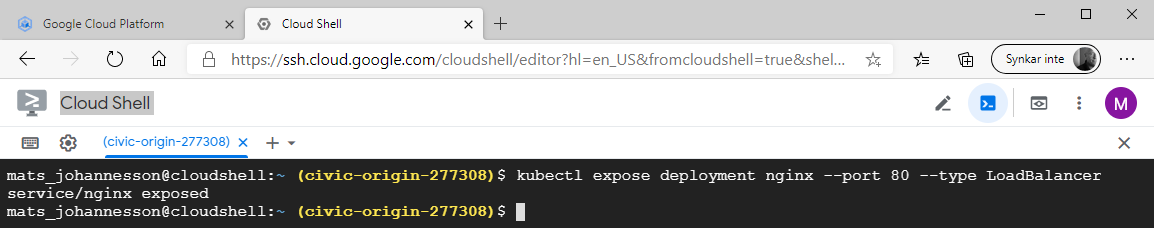

Arbetsuppgift 5: Exponera pod för åtkomst från Internet (LoadBalancer)

1. I fönstret för Cloud Shell, skriv in följande kommando och klicka på Enter:

kubectl expose deployment nginx --port 80 --type LoadBalancer

LoadBalancer exponeras som en tjänst (services). I .easec:s modul Kubernetes beskrivs de olika kopplingarna som kan göras, bland annat med NodePort.

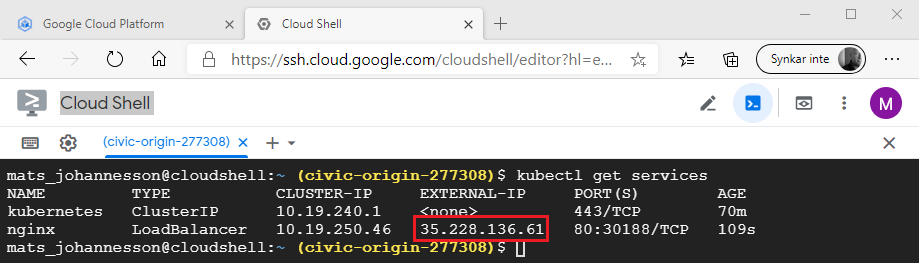

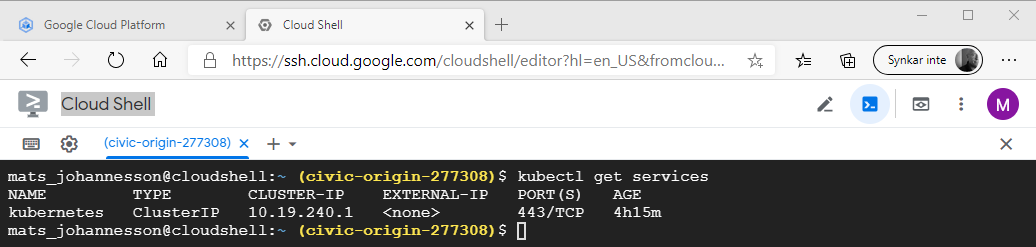

2. I fönstret för Cloud Shell, skriv in följande kommando och klicka på Enter, för att se information om extern IP-adress (Kan ta en liten stund!):

kubectl get services

Notera extern IP-adress.

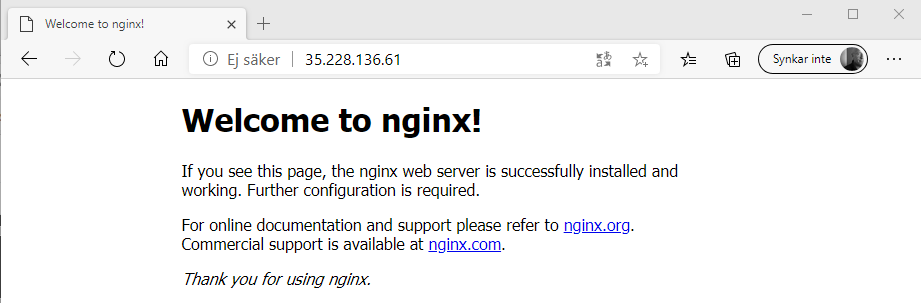

3. Öppna ny flik i din webbläsare, skriv in extern IP-adress och klicka på Enter. Standardsida för nginx visas.

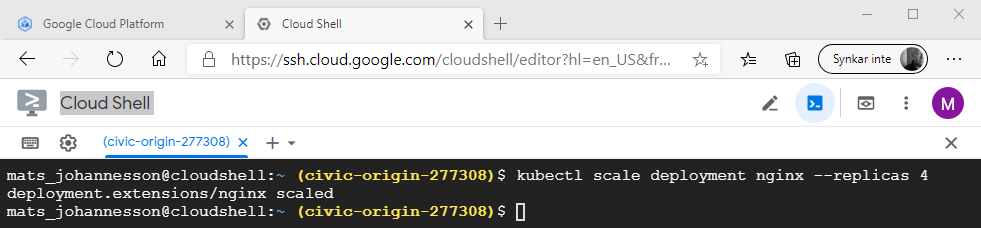

4. I fönstret för Cloud Shell, skriv in följande kommando och klicka på Enter, för att skala din deployment:

kubectl scale deployment nginx --replicas 4

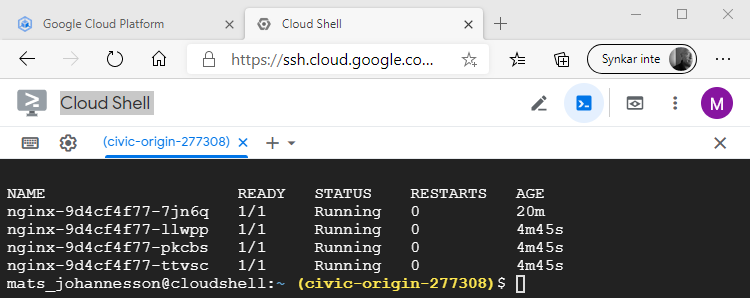

5. I fönstret för Cloud Shell, skriv in följande kommando och klicka på Enter, för att se pods:

kubectl get pods

6. I fönstret för Cloud Shell, skriv in följande kommando och klicka på Enter, för att se på vilka noder som pods körs på:

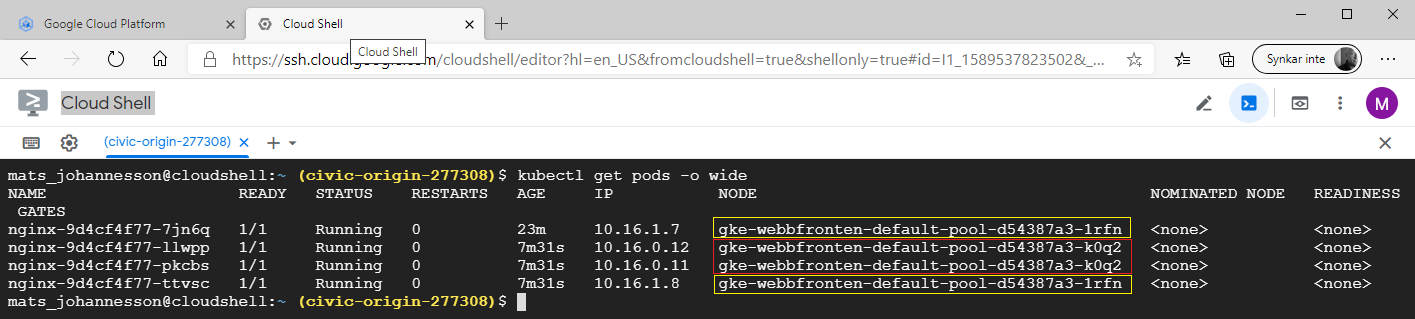

kubectl get pods -o wide

Två pods körs på respektive nod. Lägg märke till att respektive pod har en unik IP-adress.

I verklig miljö så kan du styra hur dessa pods kommer att fördelas. I .easec:s modul Kubernetes tittar vi på detta. Det kommer att komma ett blogginlägg om detta. I Kubernetes är det Scheduler som hanterar detta.

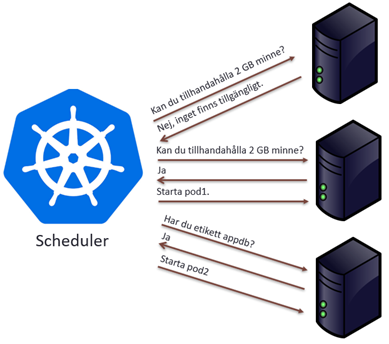

Bilden ovan visar två typer av undersökningar som kan göras (det finns fler), tillgång av resurser och etikett (label).

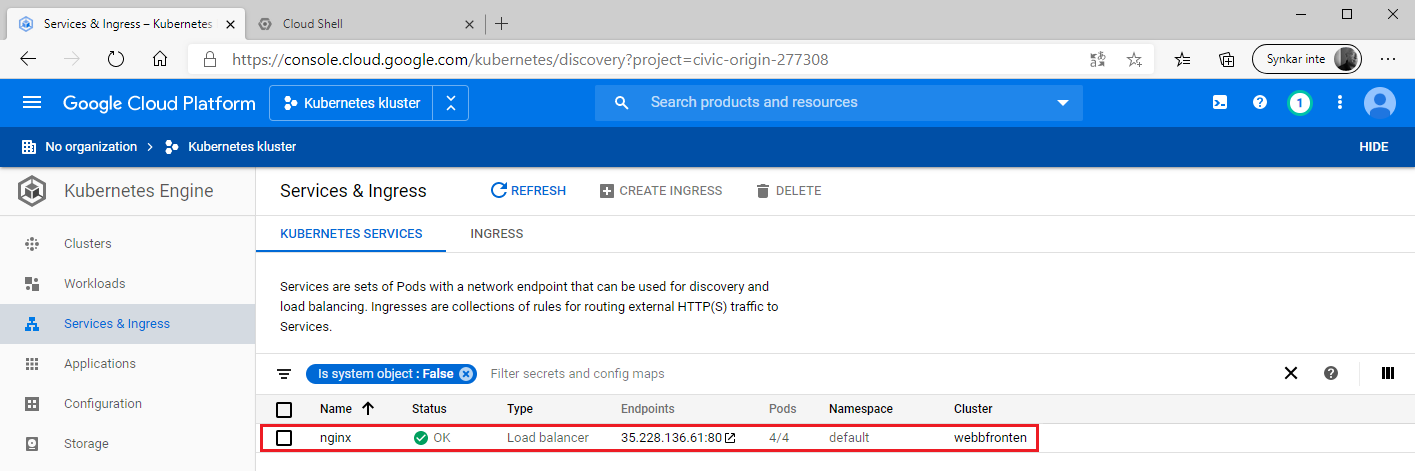

7. Återgå till konsol, expandera Navigation menu på vänstra sidan och klicka på Kubernetes Engine – Services & Ingress, notera att tjänsten visas i konsol.

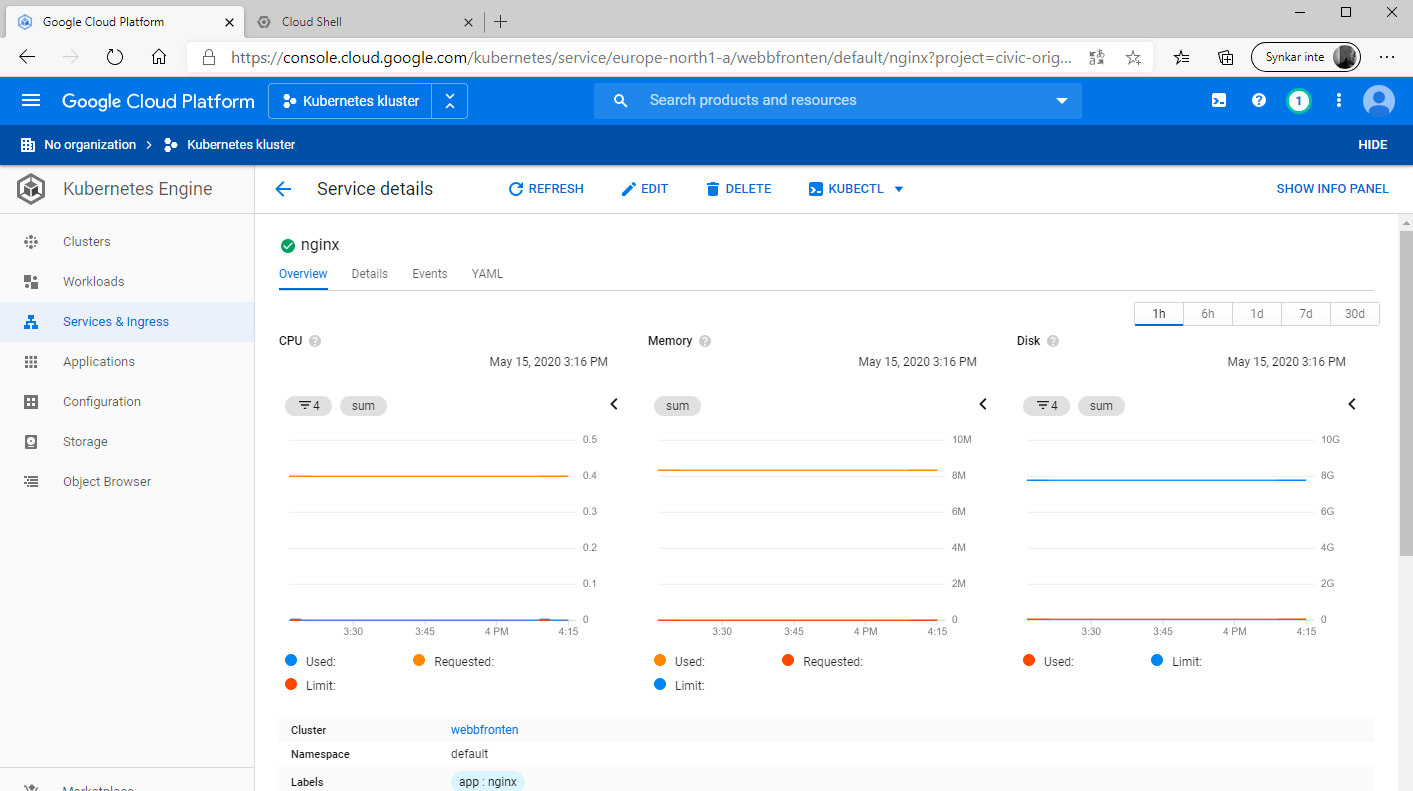

8. Dubbelklicka på din tjänst, i fliken Overview får du en översiktsbild för din tjänst.

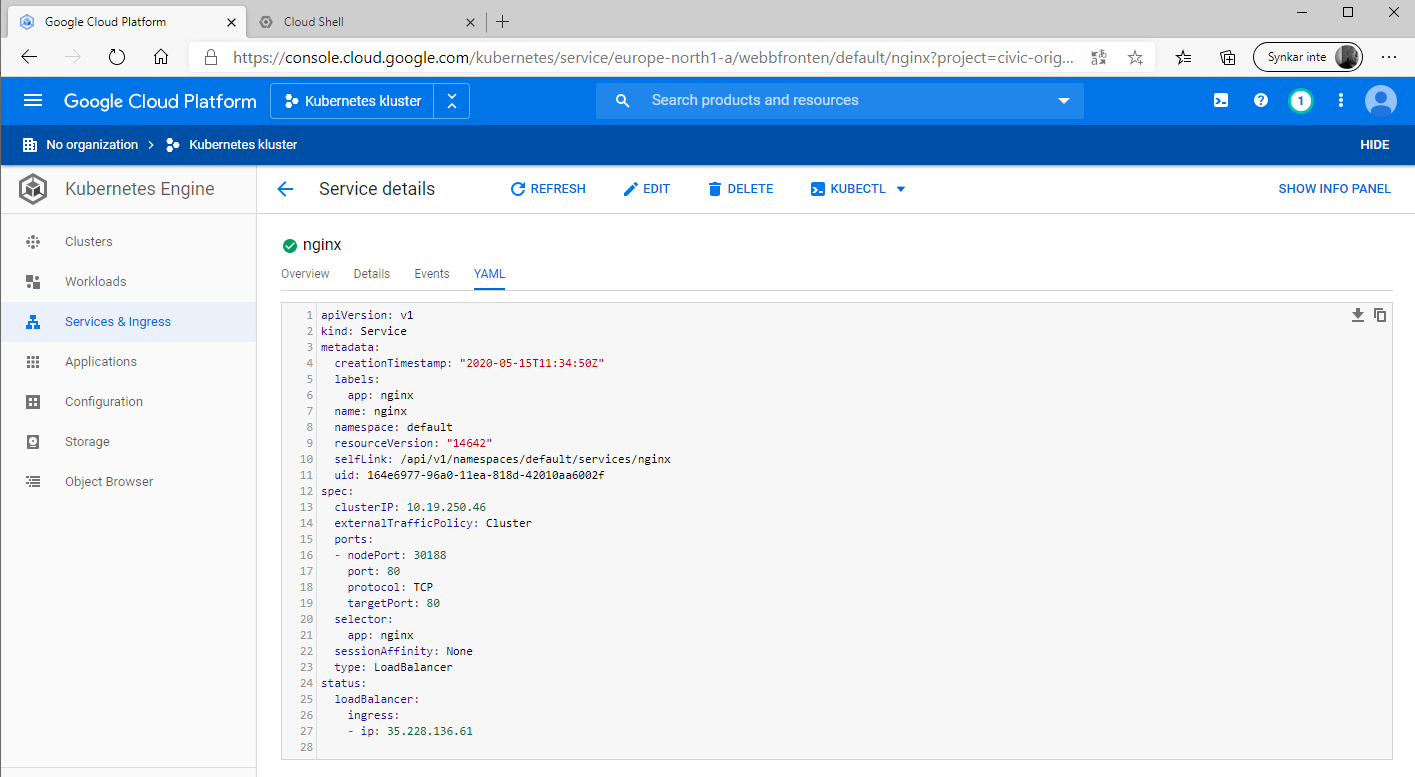

9. Klicka på fliken YAML för att se konfigurationsfil för din funktion.

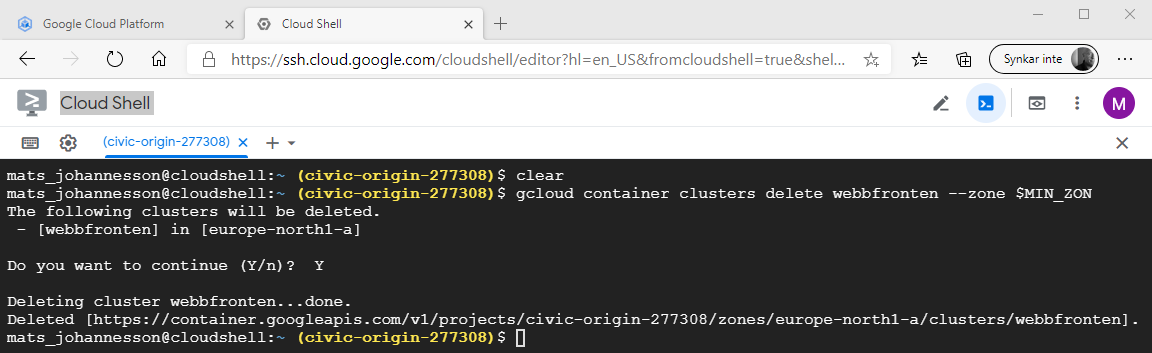

Arbetsuppgift 6: Städa upp

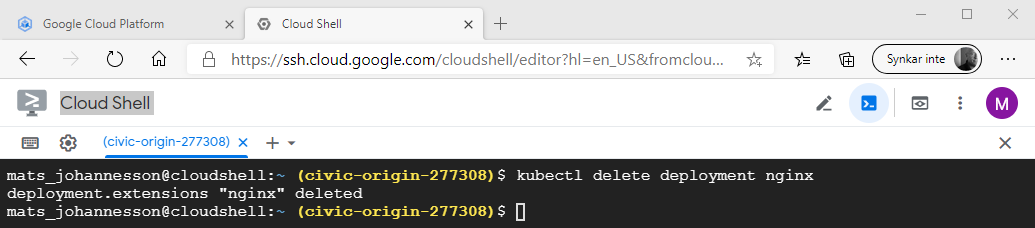

1. I fönstret för Cloud Shell, skriv in följande kommando och klicka på Enter:

kubectl delete deployment nginx

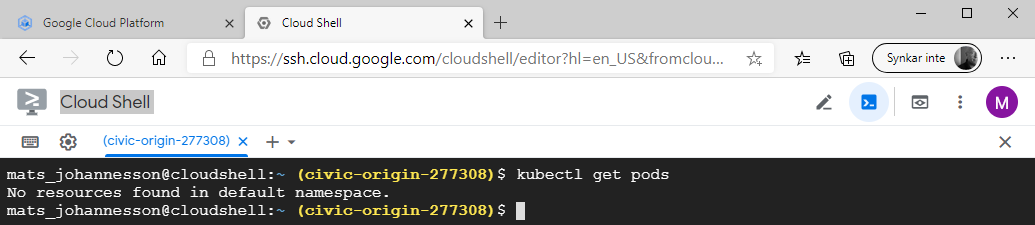

2. I fönstret för Cloud Shell, skriv in följande kommando och klicka på Enter, för att verifiera att pods är borttagna:

kubectl get pods

Kommandot resulterar i att inga pods finns.

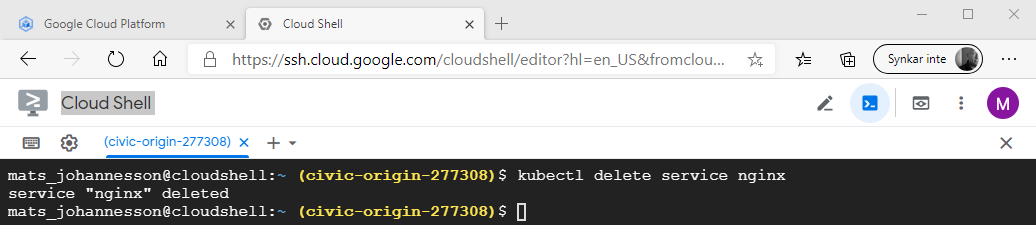

3.cI fönstret för Cloud Shell, skriv in följande kommando och klicka på Enter, för att ta bort tjänst (nginx):

kubectl delete service nginx

4. I fönstret för Cloud Shell, skriv in följande kommando och klicka på Enter, för att kontrollera att tjänst är borta:

kubectl get services

5. I fönstret för Cloud Shell, skriv in följande kommando och klicka på Enter, för att ta bort klustret:

gcloud container clusters delete webbfronten --zone $MIN_ZON

Skriv in ett Y och klicka på Enter för att bekräfta att du vill ta bort.

6. Återgå till konsol, expandera Navigation menu på vänstra sidan och klicka på Compute Engine, verifiera att noder som skapades tidigare är borta.

Du är klar!

Den 18-19 maj kör Edument AB .easec:s kurs Orkestrering i Docker online!

Läs mer här: https://www.edument.se/product/orkestrering-i-docker

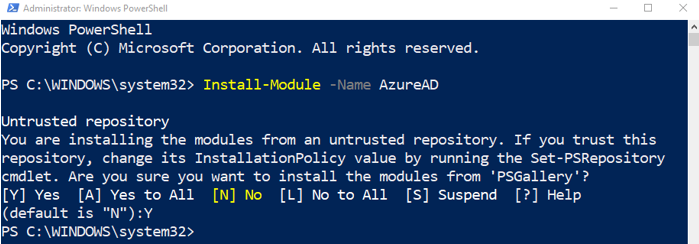

Inlägget beskriver hur du arbetar med Azure Active Directory genom att använda Graph-module. Instruktionerna kommer från .easec:s kurs Office 365 för administratören

Arbetsuppgift 1: Installera modul

1. Högerklicka på Start-knappen och välj

alternativ Windows PowerShell (Admin).

2. I dialogfönstret User Account Control, klicka på Yes.

3. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att installera modul för hantering av användare och grupper:

Install-Module -Name AzureAD

Skriv in ett Y och klicka på ENTER, för frågan om Untrusted repository.

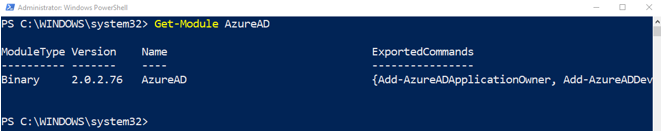

4. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att verifiera att modul har installerats:

Get-Module AzureAD

Arbetsuppgift 2: Anslut till Azure AD för din Office 365 tenant

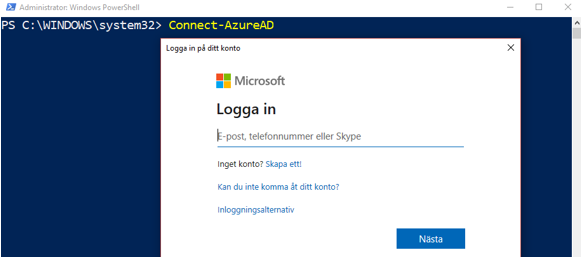

1. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter:

Connect-AzureAD

2. Skriv in E-post adress för ditt administratörskonto, klicka på Nästa.

3. Skriv in ditt lösenord och klicka på Logga in.

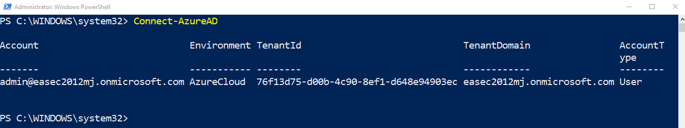

4. Detaljer om tenant visas i fönstret Administrator: Windows PowerShell.

Arbetsuppgift 3: Hantera användare med Graph

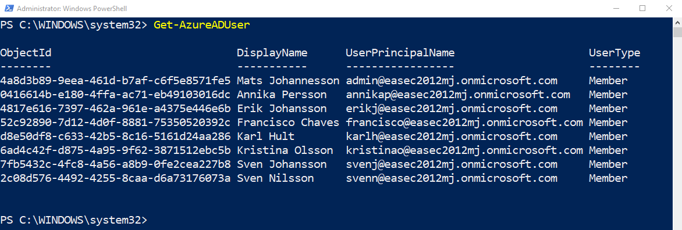

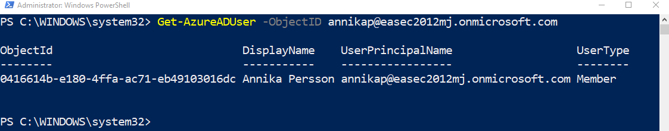

1. I fönstret Administrator: Windows Powershell, skriv in följande kommando och klicka på Enter:

Get-AzureADUser

2. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter:

Get-AzureADUser -ObjectID annikap@easecxxyy.onmicrosoft.com

I .easec:s kurs skapas tenant i Office 365 med namnet easecxxyy, där xx står för veckonummer och yy för deltagarens initialer.

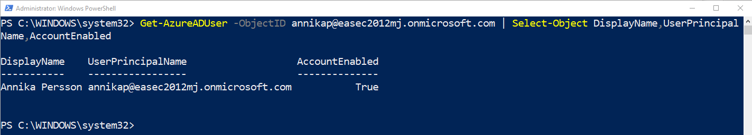

3. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att visa specifika egenskaper:

Get-AzureADUser -ObjectID annikap@easecxxyy.onmicrosoft.com | Select-Object DisplayName,UserPrincipalName, AccountEnabled

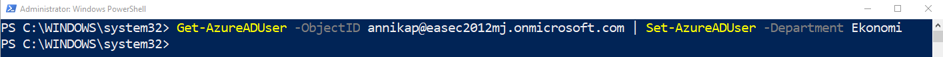

4. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter:

Get-AzureADUser -ObjectID annikap@easecxxyy.onmicrosoft.com | Get-Member

5. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter:

Get-AzureADUser -ObjectID annikap@easecxxyy.onmicrosoft.com

| Set-AzureADUser -Department Ekonomi

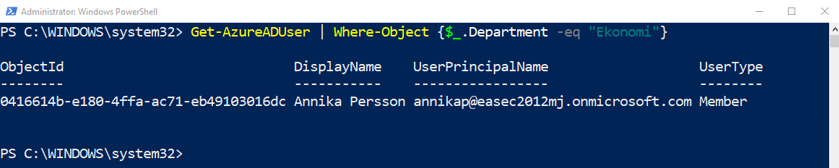

6. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter:

Get-AzureADUser | Where-Object {$_.Department -eq "Ekonomi"}

{$_.Department …} betyder just detta objekt, som skall undersökas.

Arbetsuppgift 4: Skapa och ta bort användare med Graph

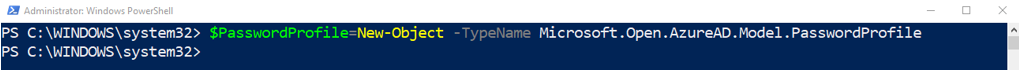

1. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att skapa profil för lösenord:

$PasswordProfile=New-Object -TypeName Microsoft.Open.AzureAD.Model.PasswordProfile

Kommandot kommer att göra en kopia (instansiera) av klassen Microsoft.Open.AzureAD.Model.PasswordProfile.

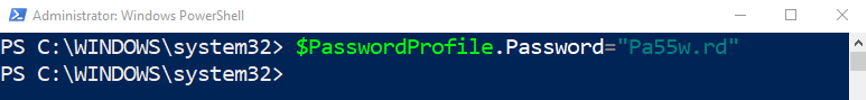

2. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att lägga till lösenord:

$PasswordProfile.Password="Pa55w.rd"

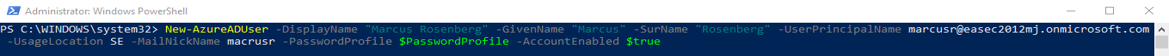

3. I fönstret Administrator: Windows

PowerShell, skriv in följande kommando och klicka på Enter, för att skapa nytt

konto:

New-AzureADUser -DisplayName "Marcus Rosenberg" -GivenName "Marcus" -SurName "Rosenberg"

-UserPrincipalName marcusr@easecxxyy.onmicrosoft.com -UsageLocation SE -MailNickName macrusr

-PasswordProfile $PasswordProfile -AccountEnabled $true

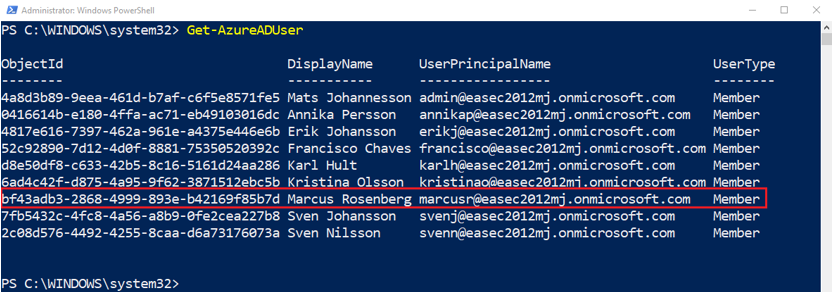

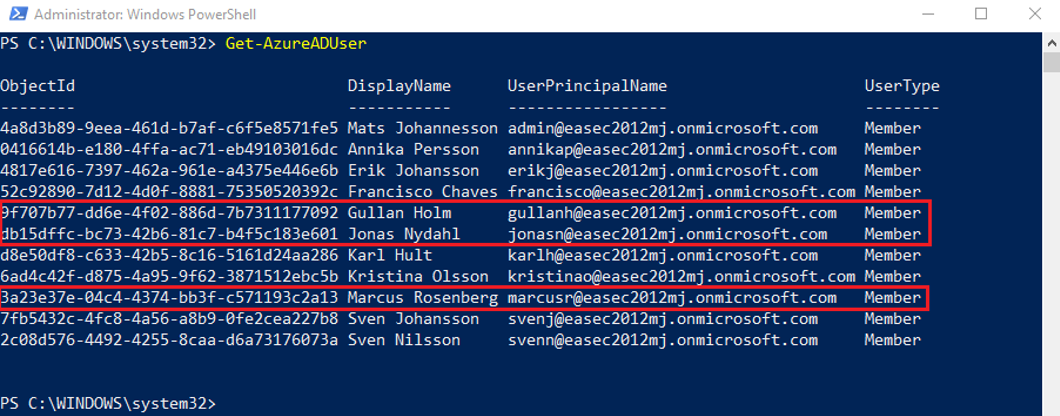

4. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att verifiera att kontot skapades:

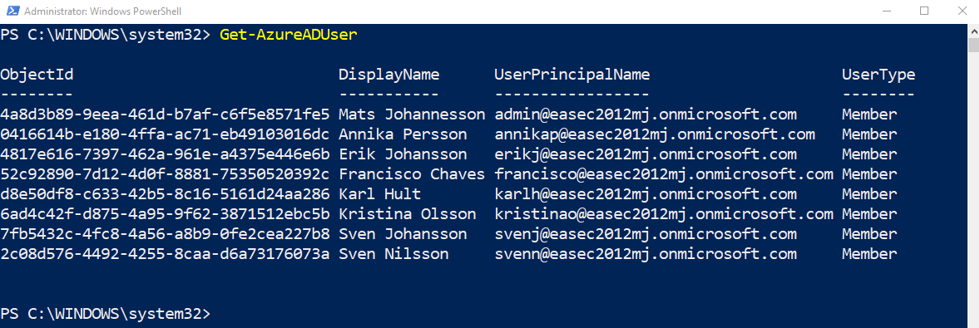

Get-AzureADUser

Notera att konto för Marcus Rosenberg finns med.

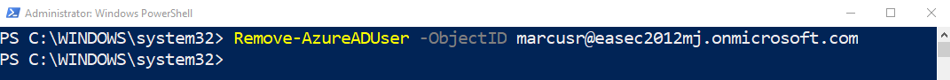

5. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att plocka bort konto du precis skapade:

Remove-AzureADUser -ObjectID marcusr@easecxxyy.onmicrosoft.com

6. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att verifiera att kontot är borta:

Get-AzureADUser

Arbetsuppgift 4: Skapa användare från CSV-fil

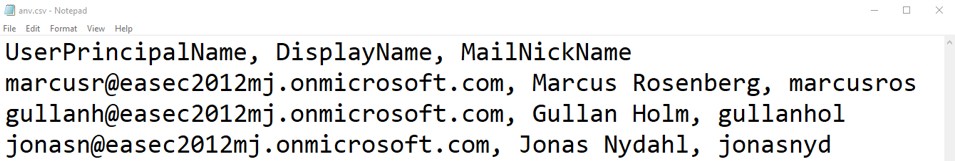

1. Öppna Anteckningarna, skriv in följande (ersätt xxyy med dina parametrar):

UserPrincipalName, DisplayName, MailNickName

marcusr@easecxxyy.onmicrosoft.com, Marcus Rosenberg, marcusros

gullanh@easecxxyy.onmicrosoft.com, Gullan Holm, gullanhol

jonasn@easecxxyy.onmicrosoft.com, Jonas Nydahl, jonasnyd

Spara undan filen med namnet anv.csv i C.\Easec (skapa katalogen om inte den finns, glöm inte att markera All Files (*.*) ).

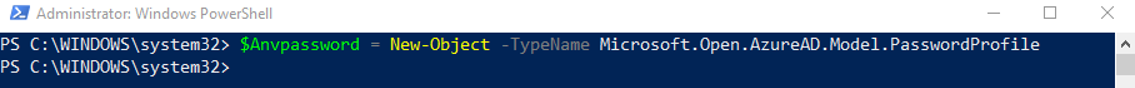

2. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter:

$Anvpassword = New-Object -TypeName Microsoft.Open.AzureAD.Model.PasswordProfile

3. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter:

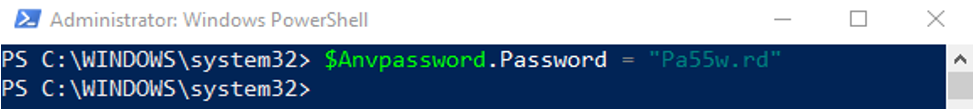

$Anvpassword.Password = ”Pa55w.rd”

4. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter:

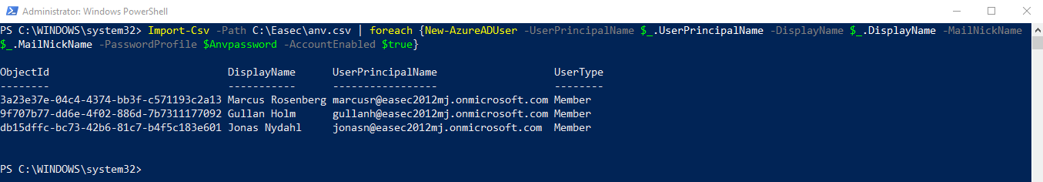

Import-Csv -Path C:\Easec\anv.csv | foreach {New-AzureADUser -UserPrincipalName $_.UserPrincipalName

-DisplayName $_.DisplayName -MailNickName $_.MailNickName -PasswordProfile $Anvpassword -AccountEnabled

$true}

5. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att verifiera att kontot är borta:

Get-AzureADUser

Notera att de nya användarna finns med.

Arbetsuppgift 5: Hantera grupper med Graph

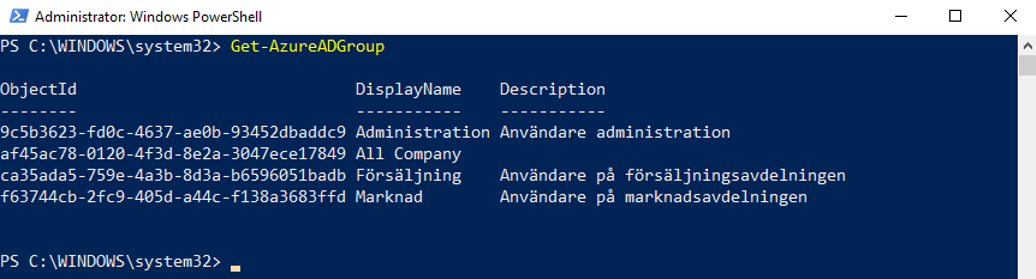

1. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att lista grupper:

Get-AzureADGroup

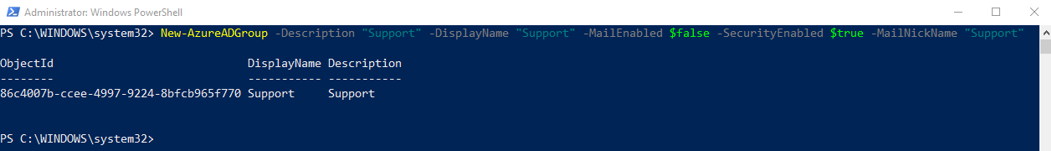

2. I fönstret Administrator: Windows

PowerShell, skriv in följande kommando och klicka på Enter, för att skapa ny

grupp:

New-AzureADGroup -Description "Support" -DisplayName "Support" -MailEnabled $false -SecurityEnabled $true

-MailNickName "Support"

Uppdatera grupp är en tvåstegsprocess,

först måste ObjectId inhämtas, sedan uppdatera gruppen.

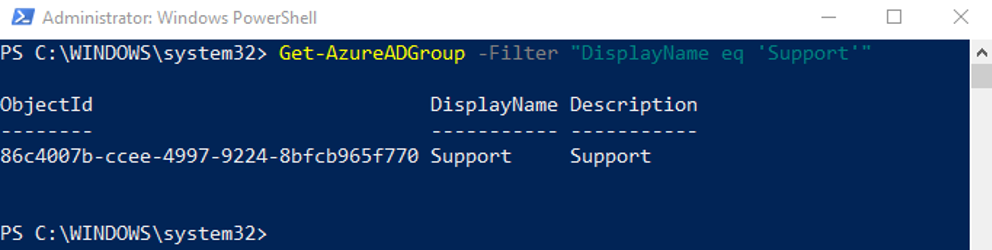

3. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att inhämta ObjectId:

Get-AzureADGroup -Filter "DisplayName eq 'Support'"

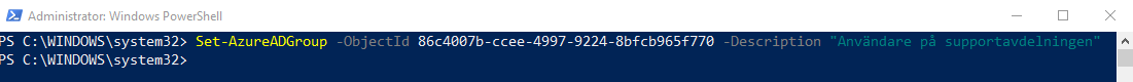

4. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att uppdatera med ny information:

Set-AzureADGroup -ObjectId <Object-Id> -Description "Användare på supportavdelningen"

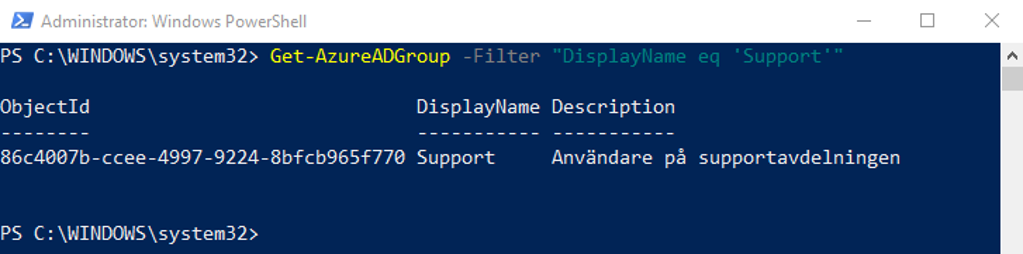

5. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att verifiera uppdateringen:

Get-AzureADGroup -Filter "DisplayName eq 'Support'"

Lägga till användare i gruppen, innehåller tre moment: skapa variabel som innehåller information om grupp, skapa variabel som innehåller information om specifik användare, uppdatera medlemskapet. Gruppägare sätts med liknande teknik, cmdlet Add-AzureADGroupOwner används istället. För att ta bort ägare, använd cmdlet Remove-AzureADGroupOwner,

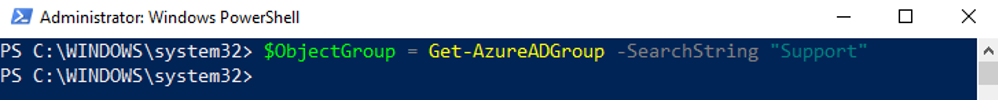

6. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att skapa variabel med gruppinformation:

$ObjectGroup = Get-AzureADGroup -SearchString "Support"

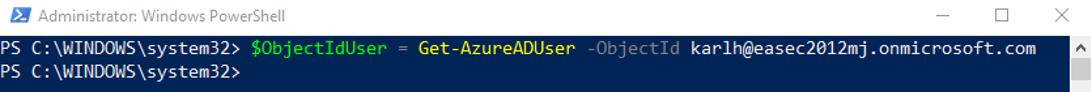

7. I fönstret Administrator: Windows

PowerShell, skriv in följande kommando och klicka på Enter:

$ObjectIdUser = Get-AzureADUser -ObjectId karlh@easecxxyy.onmicrosoft.com

Användare Karl Hult skapas i .easec:s kurs,

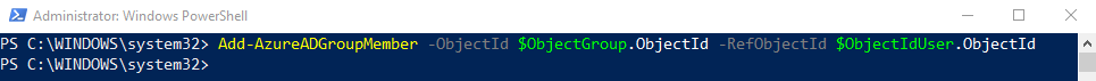

8. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att lägga till användare Karl Hult i gruppen support:

Add-AzureADGroupMember -ObjectId $ObjectGroup.ObjectId -RefObjectId $ObjectIdUser.ObjectId

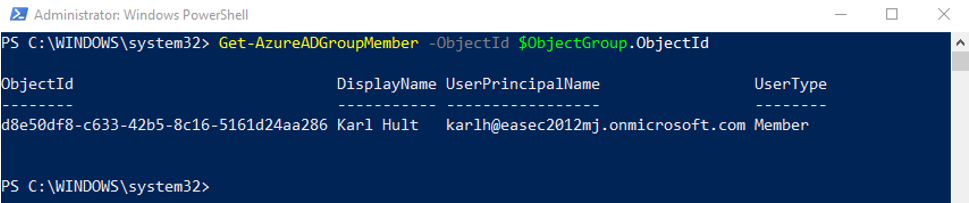

9. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att verifiera att användare har lagts till i gruppen:

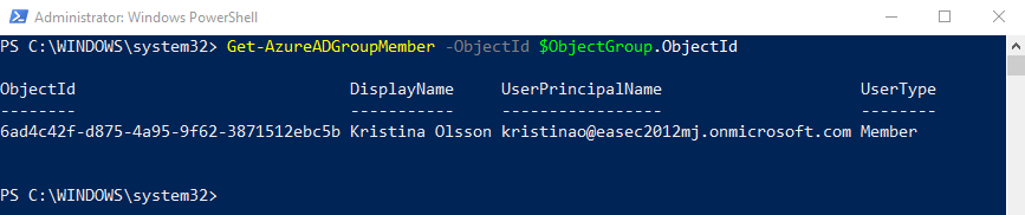

Get-AzureADGroupMember -ObjectId $ObjectGroup.ObjectId

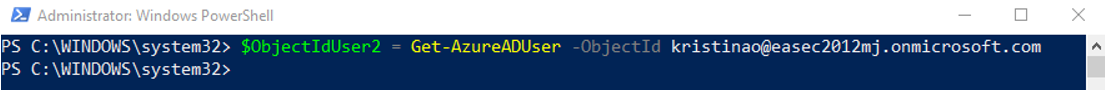

10. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter:

$ObjectIdUser2 = Get-AzureADUser -ObjectId kristinao@easecxxyy.onmicrosoft.com

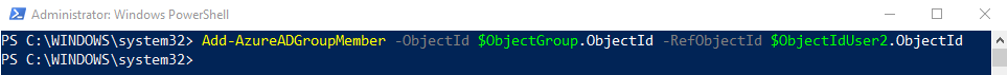

11. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att lägga till användare Karl Hult i gruppen support:

Add-AzureADGroupMember -ObjectId $ObjectGroup.ObjectId -RefObjectId $ObjectIdUser2.ObjectId

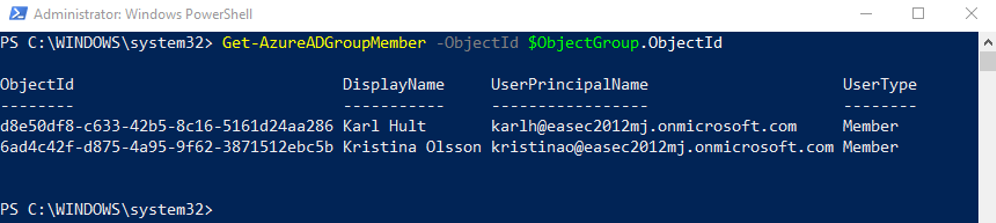

12. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att verifiera att användare har lagts till i gruppen:

Get-AzureADGroupMember -ObjectId $ObjectGroup.ObjectId

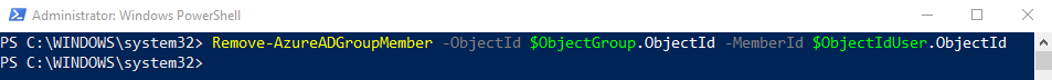

13. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att ta bort användare Karl Hult från gruppen Support:

Remove-AzureADGroupMember -ObjectId $ObjectGroup.ObjectId -MemberId $ObjectIdUser.ObjectId

14. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att verifiera att användare har tagits bort från gruppen:

Get-AzureADGroupMember -ObjectId $ObjectGroup.ObjectId

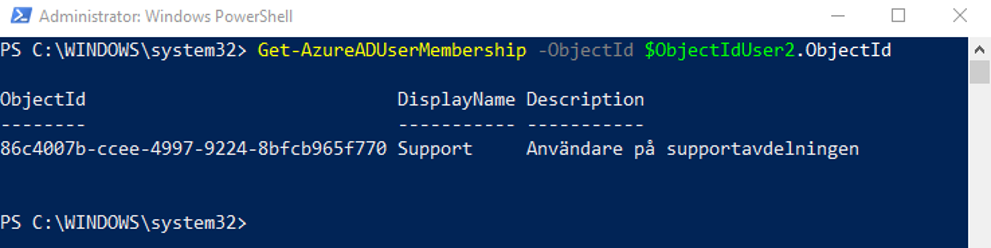

15. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att lista vilken eller vilka grupper som användare är medlem i (Kristina Olsson):

Get-AzureADGroupMembership -ObjectId $ObjectIdUser2.ObjectId

Arbetsuppgift 5: Avsluta anslutningen

1. I fönstret Administrator: Windows PowerShell, skriv in följande kommando och klicka på Enter, för att avsluta anslutning till AzureAD:

Disconnect-AzureAD

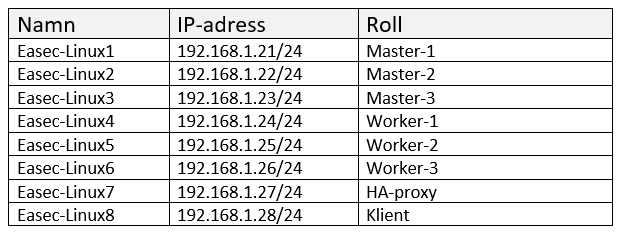

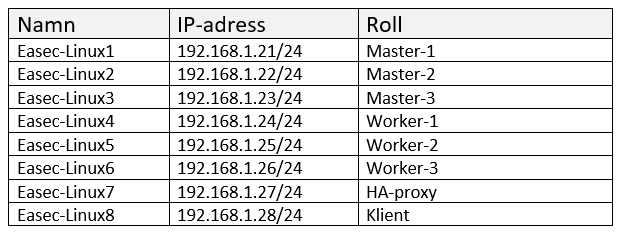

Installera worker

Rollen worker för Kubernetes kommer att installeras på easec-linux4, easec-linux5 och easec-linux6.

I .easec:s miljö är Docker redan installerat, i din miljö får du installera Docker och konfigurera Docker. För att konfigurera Docker för systemd och overlay2, se mitt blogginlägg: https://portal.easec.se/moodle/blog/index.php?entryid=43

Arbetsuppgift 1: Installera kubeadm, kubelet och kubectl

1. Anslut till Easec-Linux8 och logga på som easec med lösenordet Pa$$w0rd.

2. På Easec-Linux8 öppna terminalfönstret (ctrl+alt+t) och skriv in följande kommando och klicka på Enter, för att ansluta till easec-linux1:

ssh easec-linux4

Om det är första gången du ansluter till easec-linux4, skriv in yes och klicka på Enter. Ange Pa$$w0rd som lösenord.

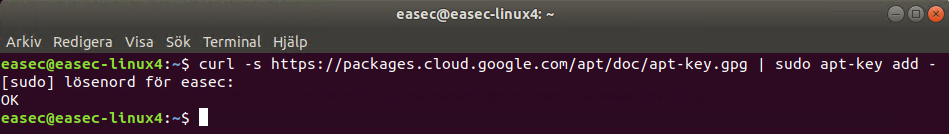

3. För att lägga till signeringsnyckel för Kubernetes, skriv in följande kommando och klicka på Enter:

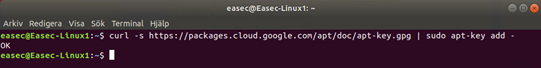

curl -s https://packages.cloud.google.com/apt/doc/apt-key.gpg | sudo apt-key add -

Ange Pa$$w0rd som lösenord för sudo.

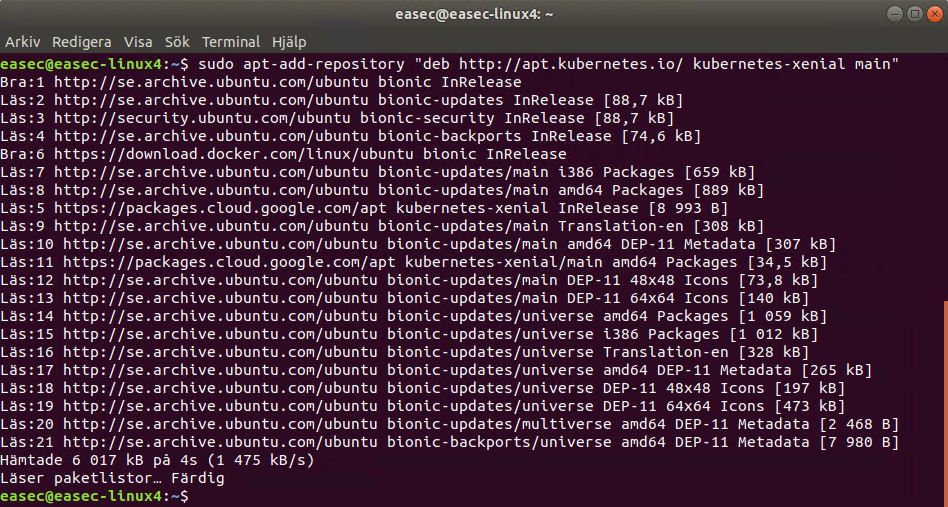

4. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att lägga till referens till förråd:

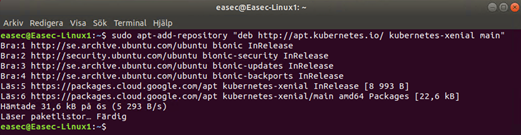

sudo apt-add-repository "deb http://apt.kubernetes.io/ kubernetes-xenial main"

5. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att lägga uppdatera referenser:

sudo apt-get update

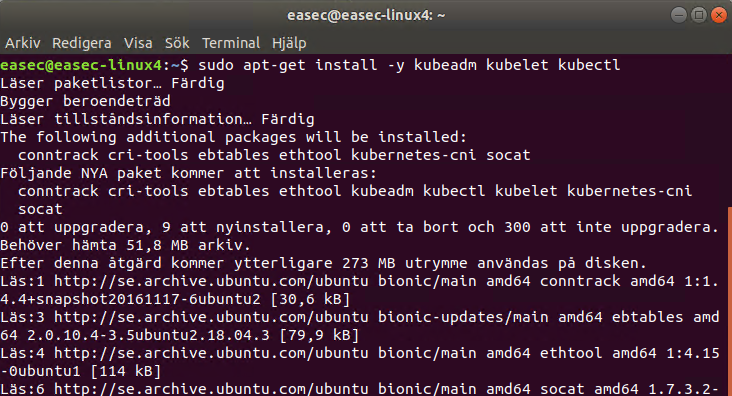

6. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att installera kubeadm kubelet och kubectl:

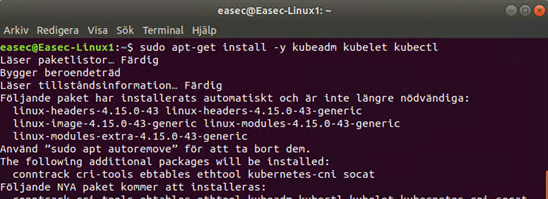

sudo apt-get install -y kubeadm kubelet kubectl

7. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att säkerställa att kubeadm, kubelet och kubectl inte uppdateras:

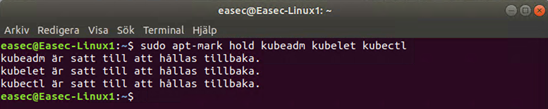

sudo apt-mark hold kubeadm kubelet kubectl

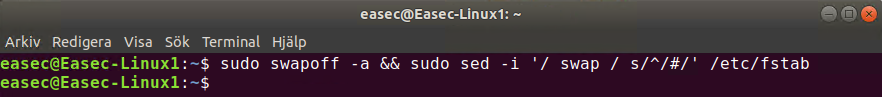

8. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att stänga av swap och göra detta permanent:

sudo swapoff -a && sudo sed -i '/ swap / s/^/#/' /etc/fstab

9. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att avsluta anslutning till easec-linux4:

exit

5. Gör om punkt 2 – 9 för easec-linux5 respektive easec-linux6.

Arbetsuppgift 2: Initiera noder

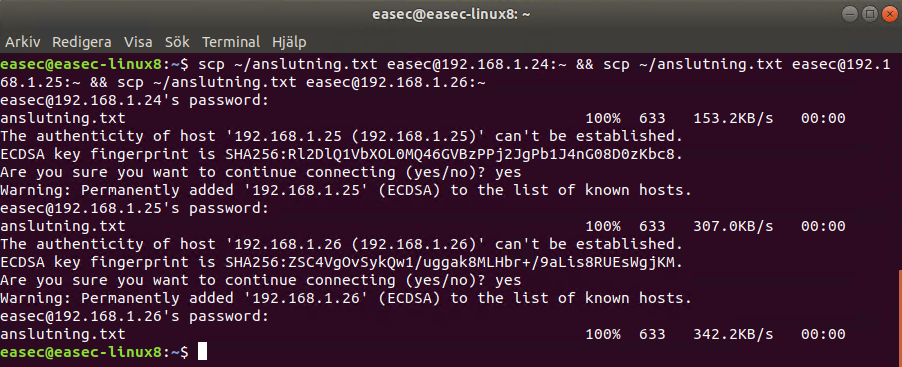

1. På Easec-Linux8, i terminalfönstret, skriv in följande kommando och klicka på Enter, för att kopiera filen anslutning.txt till easec-linux4, easec-linux5 och easec-linux6:

scp ~/anslutning.txt easec@192.168.1.24:~ && scp ~/anslutning.txt easec@192.168.1.25:~ && scp ~/anslutning.txt easec@192.168.1.26:~

Är det första gången du ansluter, får du skriva in yes och klicka på Enter. Ange Pa$$w0rd som lösenord.

2. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att ansluta till easec-linux4:

ssh easec-linux4

Ange Pa$$w0rd som lösenord.

3. I terminalfönstret, skriv in följande kommando och klicka på Enter:

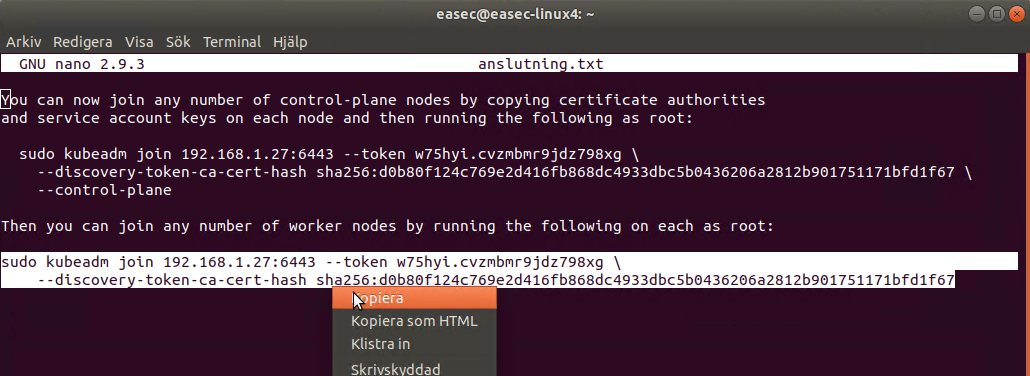

nano anslutning.txt

4. Markera nedre raderna som börjar med sudo kubeadm join (under raden "Then you can join any number of worker nodes … ", högerklicka och välj Kopiera. Klicka på ctrl+x för att avsluta nano.

5. Högerklicka först i terminalfönstret och välj klistra in.

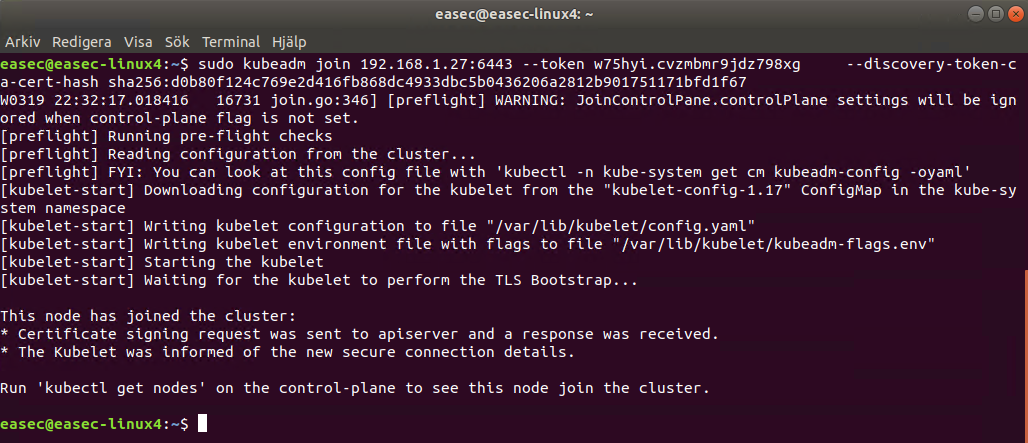

6. Klicka på Enter, ange Pa$$w0rd som lösenord för sudo.

7. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att avsluta anslutningen till easec-linux4:

exit

8. Gör om punkt 2 – 7 för easec-linux5 respektive easec-linux6.

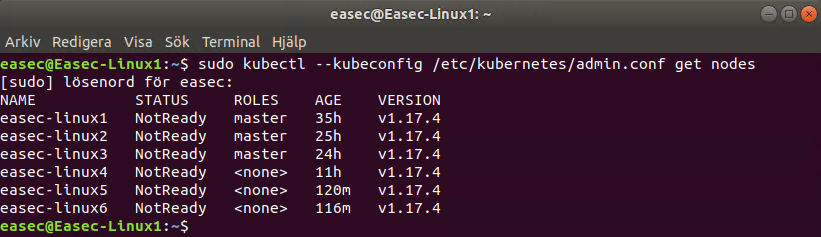

Arbetsuppgift 3: Verifiera noder

1. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att ansluta till easec-linux1 (masternod):

ssh easec-linux1

Ange Pa$$w0rd som lösenord.

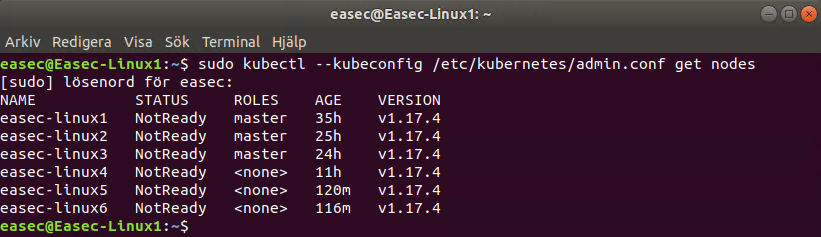

2. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att verifiera att du har sex noder, av dessa är tre master:

sudo kubectl --kubeconfig /etc/kubernetes/admin.conf get nodes

Ange Pa$$w0rd som lösenord för sudo.

I .easec:s tvådagars workshop fortsätter vi konfigurationen med:

- Installation av overlay network.

- Installation av klient på easec-linux8.

- Installation av dashboard.

- Installation av registry.

Andra dagen sätter du upp det andra alternativet med extern klustrad etcd.

Två tilläggsdagar erbjuds:

- Kubernetes i molntjänst (aws, Azure eller Google).

- Övervakning.

Installera master

Masterrollen för Kubernetes kommer att installeras på easec-linux1, easec-linux2 och easec-linux3.

I .easec:s miljö är Docker redan installerat, i din miljö får du installera Docker och konfigurera Docker. För att konfigurera Docker för systemd och overlay2, se mitt blogginlägg: https://portal.easec.se/moodle/blog/index.php?entryid=43

Arbetsuppgift 1: Installera kubeadm, kubelet och kubectl

1. Anslut till Easec-Linux8 och logga på som easec med lösenordet Pa$$w0rd.

2. På Easec-Linux8 öppna terminalfönstret (ctrl+alt+t) och skriv in följande kommando och klicka på Enter, för att ansluta till easec-linux1:

ssh easec-linux1

Ange Pa$$w0rd som lösenord.

3. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att lägga till signeringsnyckel för Kubernetes:

curl -s https://packages.cloud.google.com/apt/doc/apt-key.gpg | sudo apt-key add -

Ange Pa$$w0rd som lösenord för sudo.

4. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att lägga till referens till förråd:

sudo apt-add-repository "deb http://apt.kubernetes.io/ kubernetes-xenial main"

5. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att uppdatera referenser:

sudo apt-get update

6. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att installera:

sudo apt-get install -y kubeadm kubelet kubectl

7. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att säkerställa att kubeadm kubelet och kubectl inte uppdateras:

sudo apt-mark hold kubeadm kubelet kubectl

8. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att stänga av swap och göra detta permanent:

sudo swapoff -a && sudo sed -i '/ swap / s/^/#/' /etc/fstab

9. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att avsluta anslutning till easec-linux1:

exit

10. Gör om punkt 2 – 9 för easec-linux2 respektive easec-linux3.

Arbetsuppgift 2: Initiera masternoder

1. På Easec-Linux8, i terminalfönstret, skriv in följande kommando och klicka på Enter, för att ansluta till easec-linux1:

ssh easec-linux1

Ange Pa$$w0rd som lösenord.

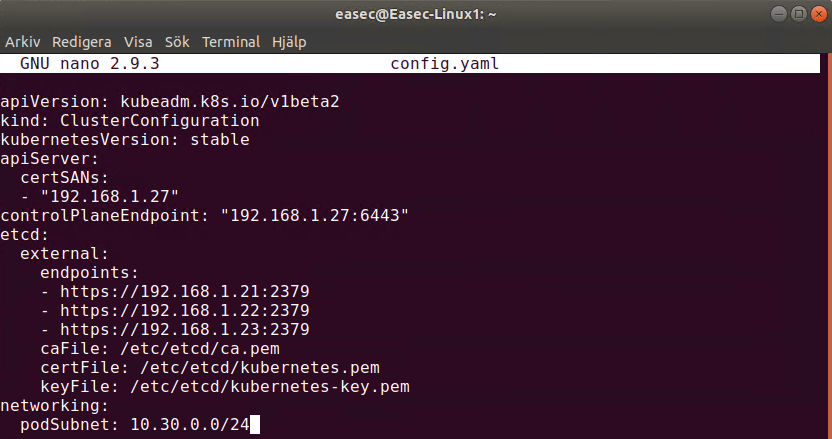

2. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att skapa konfigurationsfil (notera att denna funktion fortfarande är i beta och kan förändras!): Konfigurationsfil finns här: https://github.com/easec/cluster/blob/master/stacked/config.yaml

nano config.yaml

3. I fönstret med nano, skriv in följande:

apiVersion: kubeadm.k8s.io/v1beta2

kind: ClusterConfiguration

kubernetesVersion: stable

apiServer:

certSANs:

- "192.168.1.27"

controlPlaneEndpoint: "192.168.1.27:6443"

etcd:

external:

endpoints:

- https://192.168.1.21:2379

- https://192.168.1.22:2379

- https://192.168.1.23:2379

caFile: /etc/etcd/ca.pem

certFile: /etc/etcd/kubernetes.pem

keyFile: /etc/etcd/kubernetes-key.pem

networking:

podSubnet: 10.30.0.0/24

Klicka på ctrl+x, skriv in ett J och klicka på Enter för att spara filen.

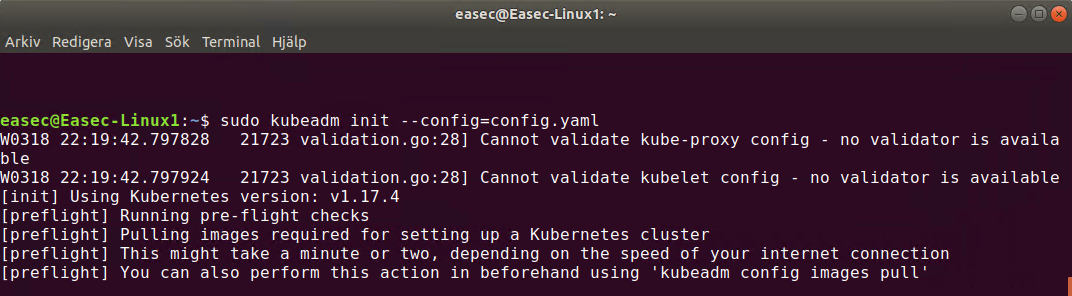

4. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att initiera första nod:

sudo kubeadm init --config=config.yaml

Skriv in Pa$$w0rd som lösenord för sudo. Detta kommer att ta en stund!

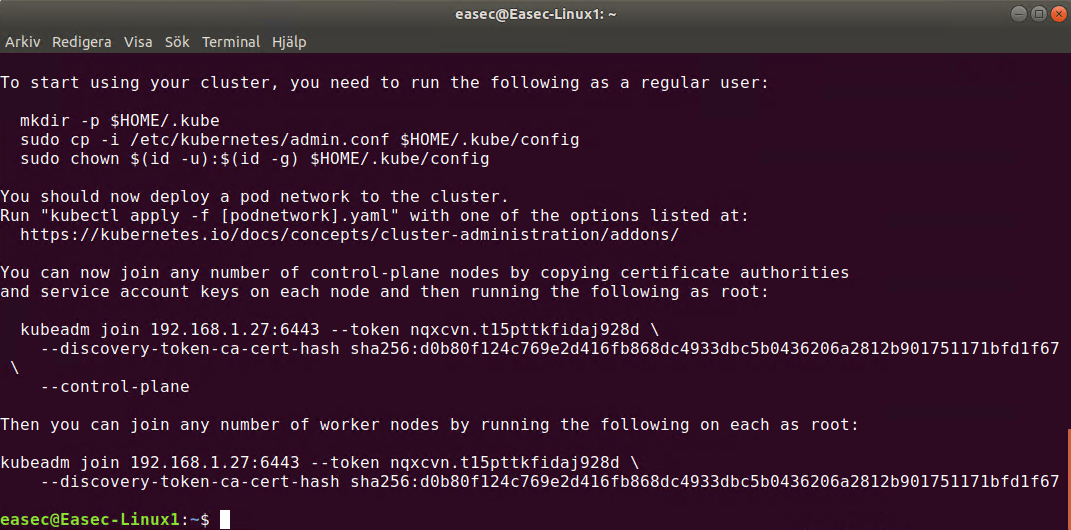

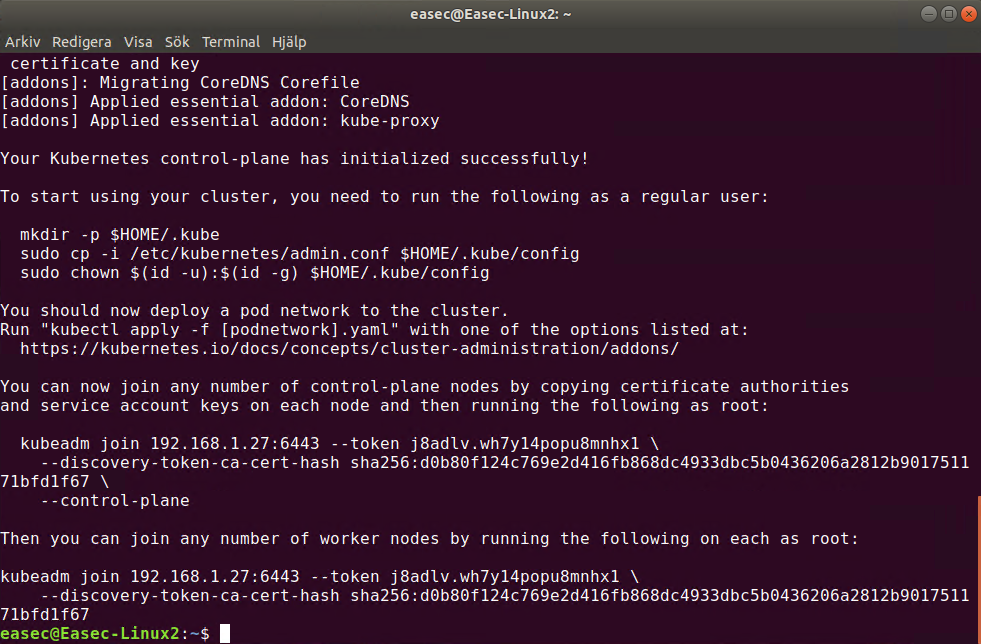

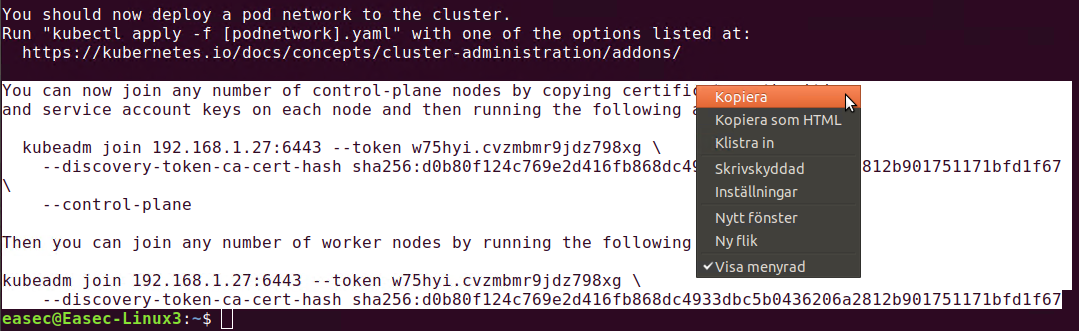

Bild ovan visas när det är klart!

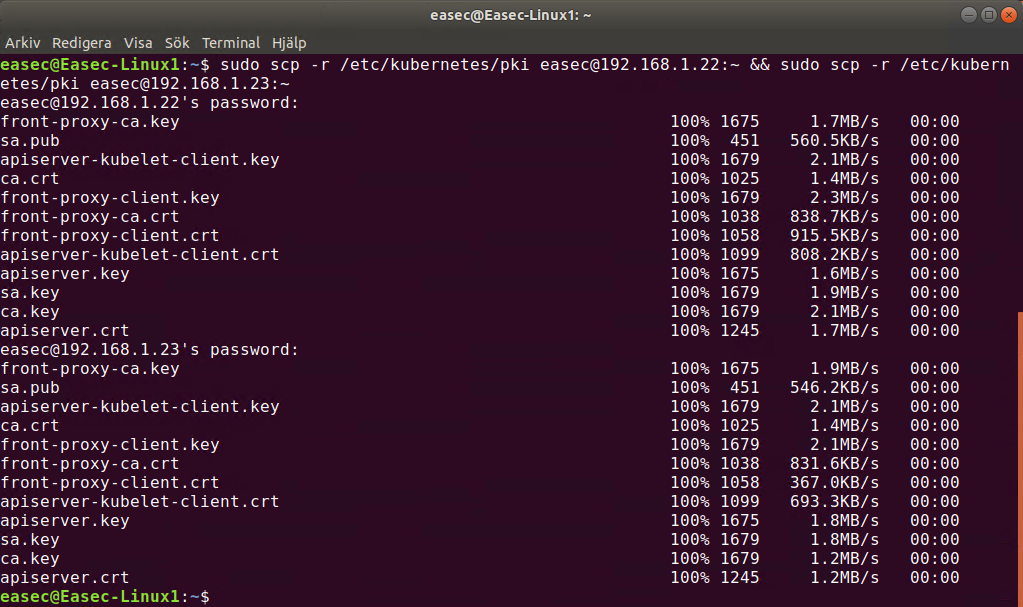

5. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att kopiera certifikat till de andra noderna:

sudo scp -r /etc/kubernetes/pki easec@192.168.1.22:~ && sudo scp -r /etc/kubernetes/pki easec@192.168.1.23:~

Ange Pa$$w0rd som lösenord för sudo.

6. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att avsluta anslutning till easec-linux1:

exit

7. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att ansluta till easec-linux2:

ssh easec-linux2

Ange Pa$$w0rd som lösenord.

8. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att ta bort certifikat och nyckel för api-server:

rm ~/pki/apiserver.*

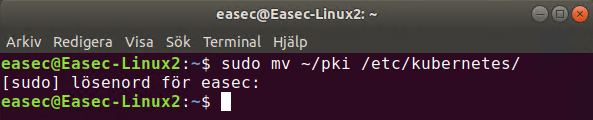

9. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att flytta certifikat till katalogen /etc/kubernetes/:

sudo mv ~/pki /etc/kubernetes/

10. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att skapa konfigurationsfil:

nano config.yaml

11. I fönstret med nano, skriv in följande:

apiVersion: kubeadm.k8s.io/v1beta2

kind: ClusterConfiguration

kubernetesVersion: stable

apiServer:

certSANs:

- "192.168.1.27"

controlPlaneEndpoint: "192.168.1.27:6443"

etcd:

external:

endpoints:

- https://192.168.1.21:2379

- https://192.168.1.22:2379

- https://192.168.1.23:2379

caFile: /etc/etcd/ca.pem

certFile: /etc/etcd/kubernetes.pem

keyFile: /etc/etcd/kubernetes-key.pem

networking:

podSubnet: 10.30.0.0/24

Klicka på ctrl+x, skriv in ett J och klicka på Enter för att spara filen.

12. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att initiera andra noden:

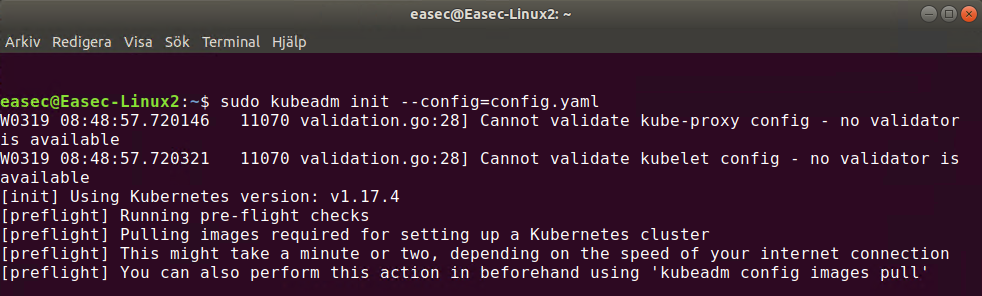

sudo kubeadm init --config=config.yaml

Skriv in Pa$$w0rd som lösenord för sudo. Precis som för easec-linux1 kommer detta att ta en stund!

Bild ovan visas när det är klart!

13. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att avsluta anslutningen till easec-linux2:

exit

14. Gör om punkt 7 – 12, för att initiera tredje noden. Innan du fortsätter med nästa steg, gör följande när du är ansluten till easec-linux3:

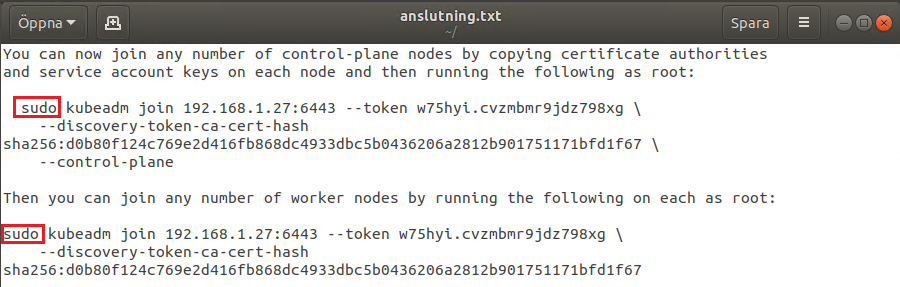

a. Markera textraderna som börjar med ”You can now join ..” enligt bild ovan, högerklicka och välj Kopiera.

b. Öppna Textredigeraren och klistra in texten.

c. Lägg till sudo innan kubeadm, både för control-plane nodes och för worker nodes, spara filen med namnet anslutning.txt.

15. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att avsluta anslutningen till easec-linux3:

exit

Installera och konfigurera etcd

etcd kommer att installeras på easec-linux1, easec-linux2 och easec-linux3. Versionen är 3.4.4 som är den senaste när denna dokumentation skrevs (200317).

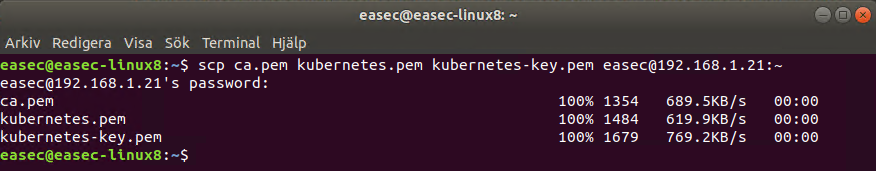

Arbetsuppgift 1: Kopiera certifikat till respektive maskin

1. Anslut till easec-linux8 och logga på som easec med lösenordet Pa$$w0rd.

2. På easec-linux8 öppna terminalfönstret (ctrl+alt+t) och skriv in följande kommando och klicka på Enter, för att kopiera certifikat till respektive maskin:

scp ca.pem kubernetes.pem kubernetes-key.pem easec@192.168.1.21:~

Ange Pa$$w0rd som lösenord. Om det är första gången du ansluter, får du skriva yes och klicka på Enter.

3. I terminalfönstret, upprepa föregående kommando, men ändra IP-adress till 192.168.1.22 respektive 192.168.1.23.

Arbetsuppgift 2: Installera etcd

1. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att ansluta till easec-linux1:

ssh easec-linux1

Om det är första gången du ansluter, får du skriva in yes och klicka på Enter, skriv därefter in Pa$$w0rd för att ansluta.

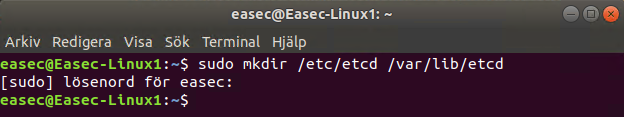

2. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att skapa konfigurationskataloger för etcd:

sudo mkdir /etc/etcd /var/lib/etcd

Skriv in Pa$$w0rd som lösenord för sudo.

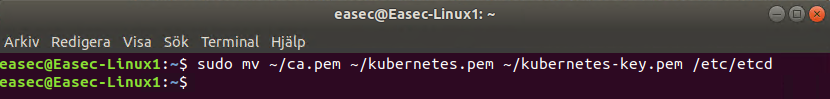

3. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att flytta certifikat till katalogen /etc/etcd:

sudo mv ~/ca.pem ~/kubernetes.pem ~/kubernetes-key.pem /etc/etcd

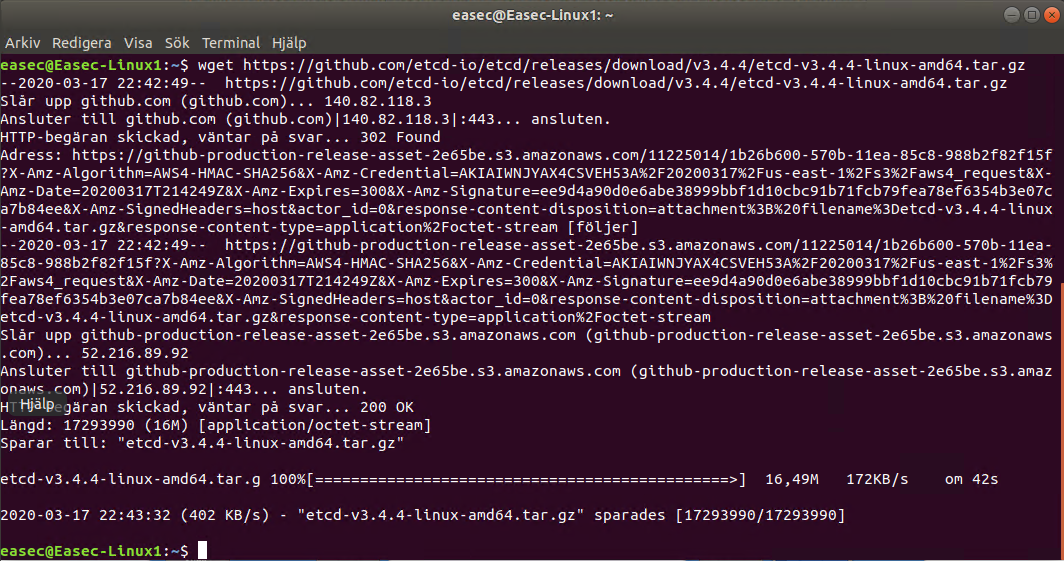

4. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att ladda ner binärer för etcd:

wget https://github.com/etcd-io/etcd/releases/download/v3.4.4/etcd-v3.4.4-linux-amd64.tar.gz

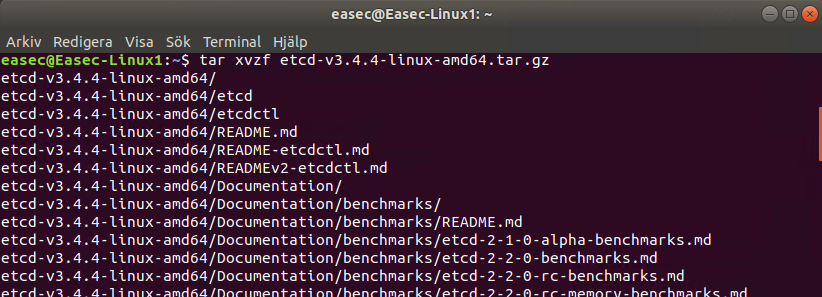

5. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att packa upp binärer för etcd:

tar xvzf etcd-v3.4.4-linux-amd64.tar.gz

6. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att flytta binärer till /usr/local/bin:

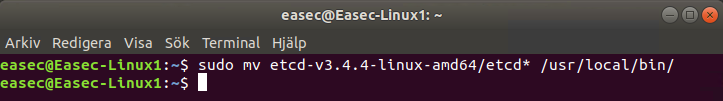

sudo mv etcd-v3.4.4-linux-amd64/etcd* /usr/local/bin/

Arbetsuppgift 3: Skapa systemd-fil

1. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att skapa systemd-fil:

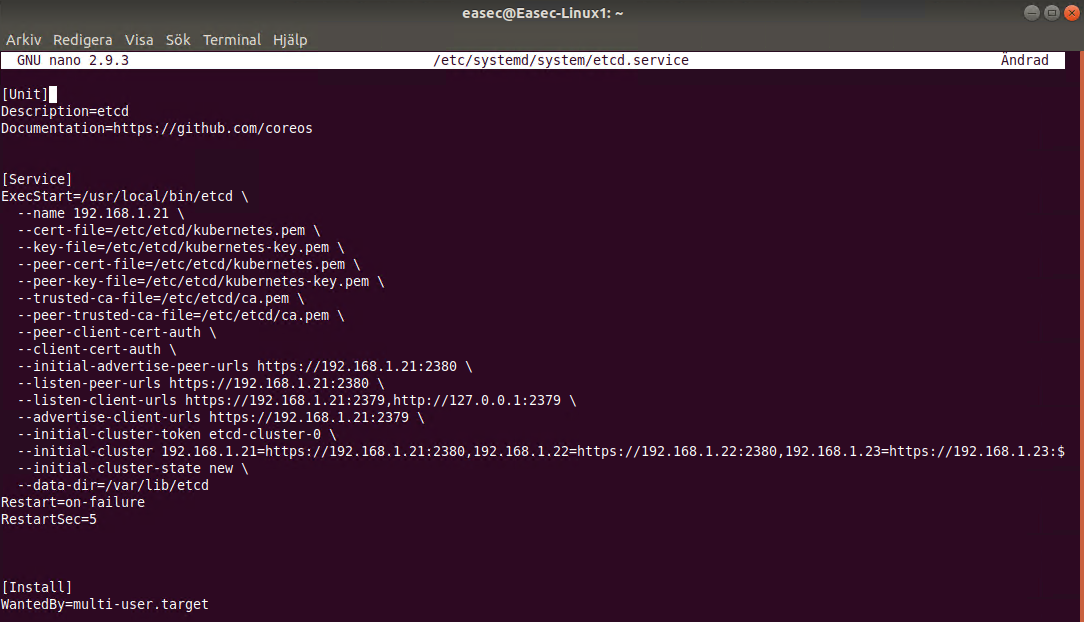

sudo nano /etc/systemd/system/etcd.service

I mitt förråd på GitHub finns etcd.service-filer för respektive maskin (https://github.com/easec/cluster/tree/master/stacked)

2. I fönstret för nano, skriv in följande:

[Unit]

Description=etcd

Documentation=https://github.com/coreos

[Service]

ExecStart=/usr/local/bin/etcd \

--name 192.168.1.21 \

--cert-file=/etc/etcd/kubernetes.pem \

--key-file=/etc/etcd/kubernetes-key.pem \

--peer-cert-file=/etc/etcd/kubernetes.pem \

--peer-key-file=/etc/etcd/kubernetes-key.pem \

--trusted-ca-file=/etc/etcd/ca.pem \

--peer-trusted-ca-file=/etc/etcd/ca.pem \

--peer-client-cert-auth \

--client-cert-auth \

--initial-advertise-peer-urls https://192.168.1.21:2380 \

--listen-peer-urls https://192.168.1.21:2380 \

--listen-client-urls https://192.168.1.21:2379,http://127.0.0.1:2379 \

--advertise-client-urls https://192.168.1.21:2379 \

--initial-cluster-token etcd-cluster-0 \

--initial-cluster 192.168.1.21=https://192.168.1.21:2380,192.168.1.22=https://192.168.1.22:2380,192.168.1.23=

https://192.168.1.23:2380 \

--initial-cluster-state new \

--data-dir=/var/lib/etcd

Restart=on-failure

RestartSec=5

[Install]

WantedBy=multi-user.target

Klicka på ctrl+x, skriv in ett J och klicka på Enter för att spara filen.

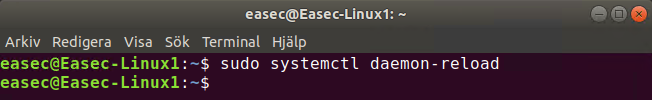

3. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att återinläsa konfigurationen för daemon:

sudo systemctl daemon-reload

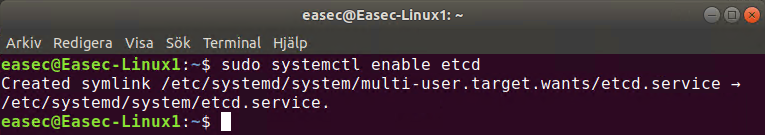

4. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att starta etcd vid uppstart:

sudo systemctl enable etcd

5. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att starta etcd:

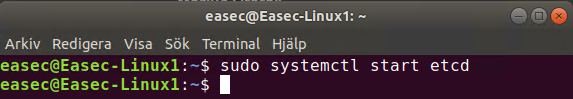

sudo systemctl start etcd

6. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att avsluta session mot Easec-Linux1:

exit

7. Gör om arbetsuppgift 2 och 3 på easec-linux2 och easec-linux3 med respektive IP-adresser.

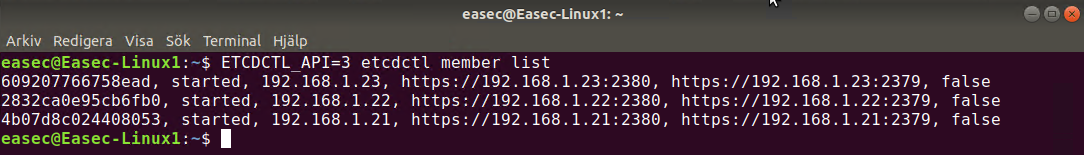

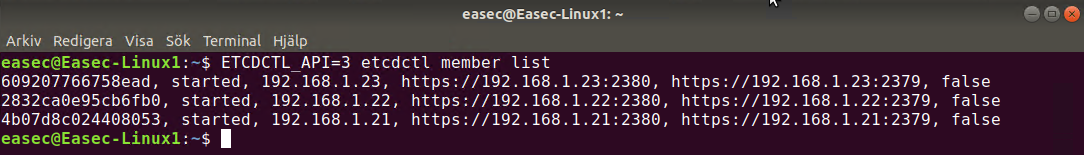

Arbetsuppgift 4: Verifiera klustret

1. I terminalfönstret, skriv in följande kommando och klicka på Enter, för att verifiera klustret och att det är igång:

ETCDCTL_API=3 etcdctl member list

Notering felsökning:

Ibland händer det att det går fel :-), när systemd används så är kommandot journalctl ett bra verktyg för att se vad som har gått fel.

Exempelvis: sudo journalctl -u etcd.service (om det är etcd), eftersom det kan bli väldigt mycket information kan det vara bra att lägga denna i en textfil, för att sedan undersöka denna textfil lite närmare sudo journalctl -u etcd.service > logg.txt.

Gör du förändringar, kör dessa kommando:

sudo systemctl daemon-reload

sudo systemctl restart etcd